با پیشرفتهای اخیر در یادگیری ماشین و بینایی کامپیوتر، روش جدیدی برای ساخت ویدیوها و تصاویر بسیار واقعی اما جعلی معرفی شده است. این فناوری به طور گسترده به عنوان “دیپ فیک” شناخته میشود و شامل جایگزین کردن چهره یک فرد با چهره فرد دیگری در یک ویدیو است؛ به طوری که چهره و حرکات لب شخص هدف به طور کاملاً واقعی به نظر میرسد. انتشار گسترده ویدیوها و تصاویر جعلی از طریق اینترنت باعث نگرانی شده است. دیپ فیک میتواند برای اهدافی مانند گمراه کردن عمدی مردم، انتشار اخبار جعلی و حتی تهدید صلح جهانی مورد استفاده قرار گیرد. از سوی دیگر، این فناوری میتواند برای اهداف سازندهتری مانند کمک به افرادی که صدای خود را از دست دادهاند نیز به کار رود. با توجه به اینکه دیپ فیک یک فناوری نسبتاً جدید (از سال 2017) است، نیاز به تحقیق و منابع بیشتری در این زمینه وجود دارد. همچنین چالشها و محدودیتهای این فناوری و ایدههای استفاده مفیدتر از آن در آینده، نیازمند بررسی بیشتر است. در این مقاله سعی کردهایم تا به صورت کلی اما تخصصی، به معرفی، کاربرد، تولید و نحوهی شناسایی محتواهای جعلی ایجاد شده توسط دیپ فیک بپردازیم تا اطلاعات جامعی از این فناوری را در اختیار شما علاقهمندان به حوزه هوش مصنوعی قرار دهیم.

دیپ فیک چیست؟

دیپ فیک نوعی فناوری است که از تکنیکهای یادگیری عمیق برای ایجاد فیلمها یا تصاویر جعلی با تغییر چهره سوژه مورد نظر با چهره شخص دیگر استفاده میکند. این فناوری میتواند محتوای جعلی بسیار واقعی و متقاعد کننده ایجاد کند و تشخیص آن را از مطالب واقعی دشوار کند. دیپ فیک میتواند در ایجاد پورنوگرافی جعلی با حضور افراد مشهور، انتشار اخبار جعلی، دستکاری صدای سیاستمداران و همچنین کلاهبرداری مالی استفاده شود. بکارگیری یادگیری عمیق برای افرادی که دانش اولیه کامپیوتر و دسترسی به سختافزار با کارایی بالا دارند، این امکان را فراهم میکند تا فیلمها و تصاویر جعلی پیچیده ایجاد کنند. این موضوع پتانسیل زیادی برای انتشار اطلاعات نادرست و فعالیتهای تقلبی دارد.

کاربردهای دیپ فیک

فناوری Deepfake دارای کاربردهای مثبت و منفی متعددی است. از یک سو، میتوان از این فناوری برای ساخت محتوای خلاقانه و سرگرم کننده استفاده کرد. از سوی دیگر، استفاده نادرست از این فناوری میتواند منجر به پیامدهای مخربی برای جامعه شود. به عنوان مثال، استفاده از Deepfake در تولید اخبار جعلی یا تصاویر توهینآمیز میتواند به ترویج اطلاعات غلط و افزایش تقلب در جامعه منجر شود. از سوی دیگر، استفاده از این فناوری در صنایع سینما و سرگرمی میتواند باعث ایجاد تجربههای جذاب و نوآورانه برای مخاطبان شود. بنابراین، لازم است که از این فناوری با دقت استفاده شود و مسائل امنیتی و اخلاقی آن مورد توجه قرار گیرد.

کاربردهای منفی

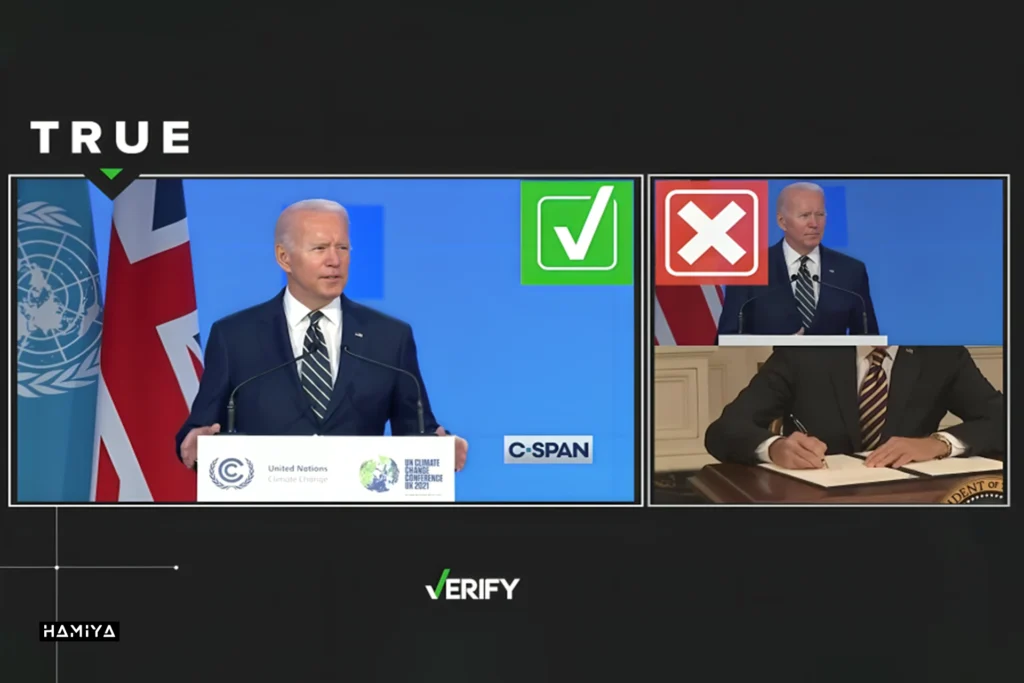

تکنولوژی Deepfake یک فناوری جدید است که در سالهای اخیر با استفاده از کاربردهای مختلف، به ویژه برای اهداف مخرب، گسترش یافته است. این فناوری میتواند برای ایجاد ویدیوها و تصاویر جعلی استفاده شود که ممکن است برای اهداف شوم مانند انتقام، باجگیری و سرقت هویت استفاده شود. یکی از نگرانیهای مردم، تکثیر ویدیوها و تصاویر بدون رضایت صاحبان آنها است که با استفاده از فناوری دیپفیک، بهویژه با تمرکز بر بازیگران زن مشهور، ایجاد میشود. علاوه بر این، رهبران و سیاستمداران نیز از جمله باراک اوباما، دونالد ترامپ، نانسی پلوسی، آنگلا مرکل، مارک زاکربرگ، بنیانگذار فیس بوک و حتی جو بایدن رئیس جمهور وقت ایالات متحده مورد هدف قرار گرفتهاند که میتواند خطرات بالقوهای برای ثبات و صلح جهانی ایجاد کند. این فناوری همچنین در هنر، صنعت فیلم و رسانههای اجتماعی نیز کاربرد دارد.

کاربردهای مثبت

فناوری دیپ فیک، علیرغم استفاده مخرب، کاربردهای مثبتی در بخشهای مختلف پیدا کرده است. این فناوری اکنون برای همه قابل دسترس است و به افزایش کاربردهای سازنده آن منجر شده است. از ایجاد آثار هنری جدید تا درگیر کردن مخاطبان با تجربیات منحصر به فرد (مانند ساختن آهنگهای جدید با صدای خوانندههایی که در قید حیات نیستند)، فناوری دیپفیک به روشهای مختلفی مورد استفاده قرار میگیرد. علاوه بر این، از آن برای اهداف تبلیغاتی، تجاری و حتی در صنعت فیلم استفاده میشود تا در زمان و هزینه ویرایش ویدیو صرفه جویی شود. همچنین، فناوری دیپ فیک برای اهداف آموزشی مورد استفاده قرار گرفته و پتانسیل بالایی را در مراقبتهای بهداشتی و درمانی نشان داده است. این فناوری امکاناتی را برای محافظت از دادههای بیمار و تولید دادههای مصنوعی برای تحقیق فراهم میکند. همچنین، از آن برای جمع آوری کمکهای مالی و ایجاد آگاهی با تولید ویدیوهایی از چهرههای تأثیرگذار استفاده شده است. تأثیر مثبت فناوری دیپفیک در بخش خردهفروشی نیز مشهود است، جایی که به طور بالقوه میتواند تجربیات واقعی مجازی را برای مصرف کنندگان ارائه دهد. به طور کلی، در حالی که فناوری دیپ فیک با پیامدهای منفی همراه بوده است، کاربردهای مثبت آن در صنایع مختلف ماهیت چند وجهی آن را برجسته میکند.

تولید دیپ فیک

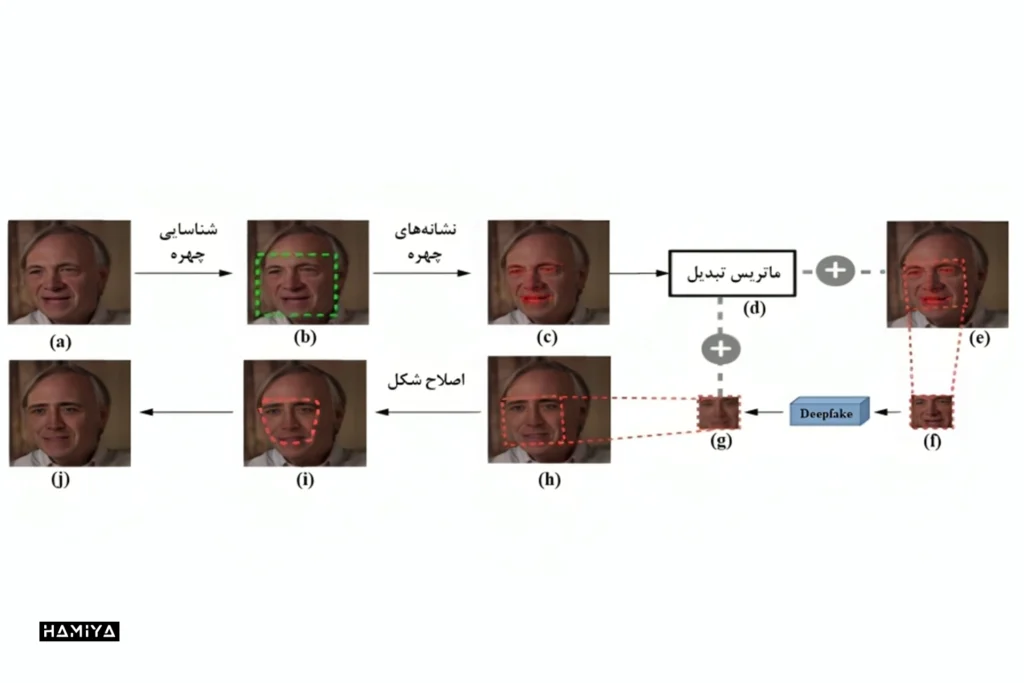

تکنیکهای Deepfake از الگوریتمهای یادگیری عمیق برای ایجاد محتوای جعلی مانند فیلمها، تصاویر، متون و صداها استفاده میکند. این تکنولوژی اغلب از شبکههای متخاصم مولد (GAN: Generative Adversarial Networks) برای تولید تصاویر و ویدیوهای جعلی استفاده میکند. دیپ فیک به دلیل دسترسی آسان و کاربردهای گستردهای که دارد، مورد توجه قرار گرفته و توانسته کاربران حرفهای و مبتدی را به خود جذب کند. از جمله استفادههای این تکنولوژی میتوان به رمزگذارهای خودکار عمیق (Deep autoencoders) اشاره کرد که بعنوان یک مدل پرکاربرد در شبکههای عمیق استفاده میشوند. این رمزگذارها از دو شبکه باور عمیق یکنواخت (uniform deep belief networks) با لایههایی برای رمزگذاری و رمزگشایی تشکیل شدهاند و معمولاً برای کاهش ابعاد و فشردهسازی تصویر استفاده میشوند. اولین نرم افزار موفق دیپ فیک، FakeApp بود که قابلیت جابجایی چهرهها را داشت. این نرم افزار برای آموزش مدل به دادههای زیادی نیاز داشت و شامل استخراج، برش، تراز و پردازش تصاویر قبل از ادغام چهرهها برای ایجاد ویدیو نهایی بود. بهعلاوه، سیستمهای عکسبرداری لحظهای از چهره وجود دارند که میتوانند جزئیات خاص چهرهی فرد را بازسازی کنند و همچنین کنترل کاملی بر روی ویدیوهای پرتره دارند. این تکنیکها کاربردهای مختلفی دارند و همچنان در حال تکامل هستند.

تکنیکهای دیگر، جزئیاتی مانند چین و چروک و حرکت دهان را برای افزایش واقع گرایی اضافه میکنند. گروهی از پژوهشگران ردیابی لحظهای صورت را پیشنهاد کردند که اشکال سه بعدی صورت و چین و چروکهای قابل قبولی را از ورودیهای با وضوح پایین، با برخی مصنوعات ایجاد میکند. در حالی که گروهی دیگر ردیابی مبتنی بر مدل را با استفاده از ویدیوی RGB-D برای سنتز فضای داخلی دهان و جزئیات بیان واقعی معرفی کرد.

فناوری Face2Face توسط Thies و همکاران ارائه شد که فضای داخلی دهان را برای دستکاری بی وقفهی ویدیو با استفاده از دادههای RGB بازنمایی میکند. چهرهها را به صورت فوتومتری ردیابی میکند و سپس عبارات را از منبع به مقصد منتقل میکند. در مقایسه با کارهای قبلی، به طور منحصربهفردی بازسازی چهره در زمان واقعی با ویدیوی RGB را امکانپذیر میکند. پژوهشگران دیگری نیز با ترکیب بافتهای دهان، سرهای سخنگو را فقط از صدا تولید کردند. این برای سخنرانی معمولی کار میکند و نیازی به ویدیو ندارد. برای درک بهتر این فناوری، اینجا را کلیک کنید.

Thies و همکاران همچنین کنترل کامل ویدیوی پرتره را با استفاده از یک شبکه پراکسی ساخته شده از یک دنباله RGB-D پیشنهاد کردند. سنتز وابسته به نمایش، پروکسی متحرک را برای نتایج فوتورئالیستی ارائه میکند. عبارات منبع ردیابی شده و به دکل پروکسی منتقل میشوند. بافتها از دنباله اولیه تا فریمهای ترکیبی به عنوان متحرکسازی پروکسی بازیابی میشوند.

ابزارهایی برای ایجاد دیپ فیک

چندین ابزار و نرم افزار برای ایجاد ویدیوهای دیپ فیک وجود دارند. برای مثال، یکی از این ابزارها FaceSwap است که از یادگیری عمیق برای تعویض چهره در تصاویر یا ویدیوها استفاده میکند. همچنین، نرم افزار “Faceswap-pytorch” کارایی بارگذاری مجموعه دادهها را افزایش میدهد و از تکنیک جایگزینی طرح چهره جدید برای نتایج بهتر استفاده میکند. همچنین، نرم افزار “DeepFaceLab” پردازش سریعتر و مبدل تعاملی را ارائه میدهد، در حالی که “DFaker” از عملکرد از دست دادن DSSIM برای بازسازی چهره در ویدیوهای Deepfake استفاده میکند.

بیشتر ابزارهای تعویض چهره از شبکههای متخاصم مولد (GAN) استفاده میکنند. رمزگذار GAN، حالات چهره و ویژگیهای مشترک بین دو چهره را استخراج میکند و این اطلاعات رمزگذاری شده را به خاطر میسپارد. سپس رمزگشا، اطلاعات دو فرد را رمزگشایی میکند تا ویژگیهای آنها را عوض کند. متمایز کننده، تصمیم میگیرد که آیا ویژگیهای صورت واقعی هستند یا خیر. کپی کردن ویژگیهای منبع در چهرهی هدف، پیچیده است که پس از آموزش از طریق رمزگذار خودکار انجام میشود. رمزگذار خودکار، نمایانگر چهره ورودی است. رمزگشای جفتی آن سپس چهره را با ویژگیهای تعویض شده بازسازی میکند. هدف این مبادلهکنندههای چهره، بهینهسازی ضرر بازسازی، ضرر خصمانه از سوی تمایز کننده و ضرر دریافتی بین منبع و هدف جعلی است. اهداف کلیدی مدیریت این ضررها برای ایجاد امکان تعویض واقعی چهره است. ساختار رمزگذار-رمزگشا، رمزگذاریها را بین افراد اصلاح میکند تا حالات مختلف چهره را هنگام تغییر هویت شخصی تغییر دهد.

شناسایی محتواهای دیپ فیک

گاهی اوقات تشخیص محتوای دیپ فیک برای یک فرد عادی بسیار دشوار است. برای تشخیص تفاوتها در ویدیوهای دیپ فیک، نیاز به تخصص و تجربهی زیادی است. تاکنون روشهای مختلفی برای مبارزه با دیپ فیک ارائه شده است، از جمله استفاده از تکنولوژی تشخیص ماشین، کمک از حوزه پزشکی قانونی و احراز هویت، همچنین اعمال مقررات مخصوص برای جلوگیری از گسترش دیپ فیک.

کارشناسان معتقدند از آنجایی که ویدیوهای Deepfake توسط الگوریتمهای خاصی ایجاد میشوند، میتوان این نوع ویدیوها را از ویدیوهای واقعی تشخیص داد. آنها بر این باورند که ناهمگونیهایی مانند نور، تاب برداشتن تصویر، صافی در برخی نواحی و تشکیل پیکسلهای غیرمعمول میتواند به تشخیص Deepfake کمک کند. همچنین، محققان یک روش برای تشخیص Deepfake از طریق تحلیل حرکت دهان و صدای قابل مشاهده در یک ضبط ارائه دادهاند. آنها از روشهای مختلفی از جمله PCA، LDA، IQM و SVM برای تشخیص Deepfake استفاده کردهاند. پس از آزمایش این روشها بر روی دادههای VidTIMIT، مشخص شد که برخی از روشهای پیشرفته نیز قادر به شناسایی محتوای جعلی نیستند.

به عنوان مثال تشخیص چهره مبتنی بر یادگیری عمیق با تکنیک VGG و Facenet قادر به تشخیص Deepfakes نیستند. اگرچه روشهای اولیه تشخیص دیپ فیک قادر به اندازهگیری پلک زدن نبودند، اما روشهای اخیر، نتایج امیدوارکنندهای را برای تشخیص پلک زدن در ویدیوی منبع و ویدیوی هدف نشان دادند. هدف نویسندگان این بود که با استفاده از تکنیکهای جدید یادگیری عمیق و با کمک شبکههای عصبی پیچشی (CNN: convolutional neural networks)، جعلهای مربوط به چهره را به طور خودکار و مناسب تشخیص دهند.

هنگامی که دادههای منبع با استفاده از روشهای یادگیری عمیق CNN و GAN ساخته میشوند، مدلهای پزشکی قانونی برای تشخیص جعلیات با مشکلات شدیدی روبرو میشوند. برای اجتناب از مشکلات سازگاری، محققان روشی را پیشنهاد کردند که از تعمیم و عمومیت بخشی پشتیبانی میکند و میتواند مکان دستکاری شده را به راحتی پیدا کند. همچنین برخی محققان کوشیدند تا تعویض چهرهای که توسط چندین نرم افزار موجود مانند Deepfake، face2face، faceswap ایجاد میشوند را با استفاده از شبکههای معمولی و واحدهای بازگشتی شناسایی کنند.

شناسایی بر اساس مصنوعات متعدد

تحقیقات مختلفی برای تشخیص ویدیوهای جعلی انجام شده است. یک گروه از محققان از شبکههای عصبی پیچشی برای تشخیص ویدیوهای Deepfake استفاده کردهاند و نتایج بهتری نسبت به تشخیص حالت سر برای چهرههای جلویی نشان دادهاند. همچنین گروه دیگری از محققان روشی برای ردیابی پلک زدن در ویدیوهای جعلی با استفاده از مدل CNN/RNN توصیف کردهاند. مقایسه چهرههای اصلی و جعلی تولید شده با استفاده از یک مدل اختصاصی CNN، تشخیص مصنوعات در ویدیوهای جعلی را بیشتر نشان داده است.

تشخیص ویدیوی جعلی مبتنی بر طبقهبندی باینری

هدف مقالات و پژوهشهای ارائه شده، شناسایی فیلمها و تصاویر جعلی با استفاده از تکنیکهای مختلف است. محققان در این مقالات بر روی استفاده از شبکههای عصبی کپسولی، ابزار تشخیص برای شناسایی محتوای جعلی تولید شده توسط ابزارهای تولید دیپ فیک، روشهای تشخیص محتوای جعلی با استفاده از شبکههای عصبی مکرر و رمزگذار خودکار آگاه از محل (LAE: Locality-aware Auto Encoder) و تکنیکهای تشخیص جعل مبتنی بر شبکههای عصبی و قابلیت انتقال تمرکز کردهاند. این مقالات بینشهایی را در مورد رویکردها و فناوریهای مختلف مورد استفاده در تشخیص محتوای رسانهای جعلی ارائه میکنند.

تفاوتهای زمانی در ویدیوهای دیپفیک با استفاده از تکنیکهای مختلفی مانند ترکیب شبکه پیچشی DenseNet و سلولهای واحد مکرر در R-CNN برای شناسایی ناسازگاریهای چهارچوب برطرف میشوند. از LRCN برای شناسایی فرکانس چشمک زدن استفاده میشود و نشان میدهد که ویدیوهای دیپفیک نرخ چشمکزنی کمتری نسبت به ویدیوهای اصلی دارند. مصنوعات تابدهندهی صورت برای کشف تفاوتهای وضوح، مورد استفاده قرار میگیرند در حالی که پزشکی قانونی، پکیج ویژگیها را از چهرهها استخراج میکند و با استفاده از شبکههای کپسولی آنها را طبقهبندی میکند. ترکیب CNN و LSTM برای رفع ناسازگاریهای درون چهارچوبی و زمانی به کار میرود، در حالی که MesoNet از CNN برای شناسایی محتوای ویدیویی جعلی استفاده میکند. علاوه بر این، تعمیم تکنیکهای GAN و استفاده از طبقهبندیکنندههایی مانند SVM، RF و MLP برای تمایز بین محتوای واقعی و ساختگی مورد بررسی قرار میگیرند. رگرسیون لجستیک و شبکههای عصبی نیز برای طبقهبندی بافتهای صورت و مقایسه آنها با بافتهای واقعی استفاده میشوند، در حالی که تحلیل PRNU برای تشخیص الگوهای بین ویدیوهای جعلی و معتبر پیشنهاد شده است.

معرفی وبسایت و چندین نرمافزار برای ساخت تصاویر جعلی و تعویض چهره

- وبسایت Deepfakes Web

- نرم افزار SpeakPic (برای اندروید، iOS و ویندوز)

- نرم افزار ZAO (برای اندروید و iOS)

- نرم افزار FaceApp (برای اندروید و iOS)

- نرم افزار Reface (برای اندروید و iOS)

- نرم افزار DeepFaceLab (برای ویندوز)

- نرم افزار FakeApp (برای ویندوز)

- نرم افزار Deepfake Studio (برای اندروید و iOS)

جمع بندی

در این مقاله به مقایسه بین تسلیحات دیپفیک و تکنیکهای تشخیص آنها پرداخته شده است. از یک سو، امکانات استفاده مثبت از فناوری دیپفیک در زمینههایی مانند فیلم و رسانه و بازسازی صدا بررسی شده است. از سوی دیگر، نگرانیهای مربوط به سوء استفاده و آسیبهای احتمالی از انتشار اطلاعات نادرست از طریق ویدئو و تصاویر دستکاری شده مورد بررسی قرار گرفته است. این مقاله به این نکته اشاره میکند که استفاده نادرست از فناوری دیپفیک میتواند به شخصیتهای عمومی و سیاستمداران آسیب برساند و اعتماد عمومی را به خطر بیندازد.

این مقاله بحث میکند که استفاده از روشهای تشخیص بهتر، مقررات و آگاهی عمومی میتواند به کاهش خطرات کمک کند. اما چالشها همچنان باقی میمانند، زیرا تکنیکهای تولید، به سرعت در حال تکامل برای ایجاد تصاویر جعلیِ باورپذیرتر هستند. نیاز به تحقیقات بیشتر در مورد شناسایی قوی و مجموعه دادههای معتبر وجود دارد. حتی انتصاب دقیق دیپ فیک برای ناظران انسانی بدون آموزش فنی دشوار است.

هوش مصنوعی قادر است تصاویر و ویدئوها را به صورت پیچیده تغییر دهد، اما این امر میتواند امنیت و اعتماد به اطلاعات را تهدید کند. دیپ فیکها میتوانند آسیبهای اجتماعی ایجاد کنند و نیازمند پاسخگویی هماهنگ از سوی رهبران فناوری، قانونگذاران و محققان هستند. برای مقابله با این چالشها، بهتر است به راهحلهای سازنده مانند آگاهیبخشی توجه کرد تا از خطرات حفاظت کرد. در کل، بررسی دقیق و بحث جامع در مورد دیپ فیک میتواند به بهبود سیاستها و حفاظتهای فناوری کمک کند.

اگر محتوای ما برایتان جذاب بود و چیزی از آن آموختید، لطفاً لحظهای وقت بگذارید و این چند خط را بخوانید:

ما گروهی کوچک و مستقل از دوستداران علم و فناوری هستیم که تنها با حمایتهای شما میتوانیم به راه خود ادامه دهیم. اگر محتوای ما را مفید یافتید و مایلید از ما حمایت کنید، سادهترین و مستقیمترین راه، کمک مالی از طریق لینک دونیت در پایین صفحه است.

اما اگر به هر دلیلی امکان حمایت مالی ندارید، همراهی شما به شکلهای دیگر هم برای ما ارزشمند است. با معرفی ما به دوستانتان، لایک، کامنت یا هر نوع تعامل دیگر، میتوانید در این مسیر کنار ما باشید و یاریمان کنید. ❤️