اخلاق هوش مصنوعی مجموعهای از اصول و روشهای اخلاقی است که به منظور هدایت، توسعه و استفاده مسئولانه از فناوری هوش مصنوعی به کار میرود. از آنجایی که هوش مصنوعی به جزء جداییناپذیر محصولات و خدمات تبدیل شدهاست، سازمانها شروع به تدوین آیین نامه های اخلاقی برای هوش مصنوعی کردهاند.

یک آیین نامه اخلاقی هوش مصنوعی، که با عنوان «بستر ارزشهای هوش مصنوعی» نیز شناخته میشود، بیانیهای حقوقی است که بهطور رسمی نقش هوش مصنوعی را در ارتباط با توسعهی مستمر نژاد بشر تعریف میکند. هدف از تدوین یک آیین نامه اخلاقی هوش مصنوعی، ارائهی رهنمود به ذینفعان در مواجهه با تصمیمات اخلاقی مرتبط با استفاده از هوش مصنوعی است.

آیساک آسیموف، نویسندهی رمانهای علمی-تخیلی، سالها پیش از توسعهی هوش مصنوعی مستقل، خطرات بالقوهی چنین عاملهایی را پیشبینی کرد و برای محدود کردن این ریسکها، «سه قانون رباتیک» را خلق کرد. در این آیین نامه اخلاقی، قانون اول به رباتها دستور میدهد که به انسانها آسیب نرسانند یا با عدم دخالت، باعث آسیب به انسانها نشوند. قانون دوم، رباتها را ملزم به اطاعت از انسانها میکند، مگر اینکه دستورات مغایر با قانون اول باشند. قانون سوم نیز از رباتها میخواهد تا از خودشان محافظت کنند، به شرطی که این کار با دو قانون اول در تضاد نباشد.

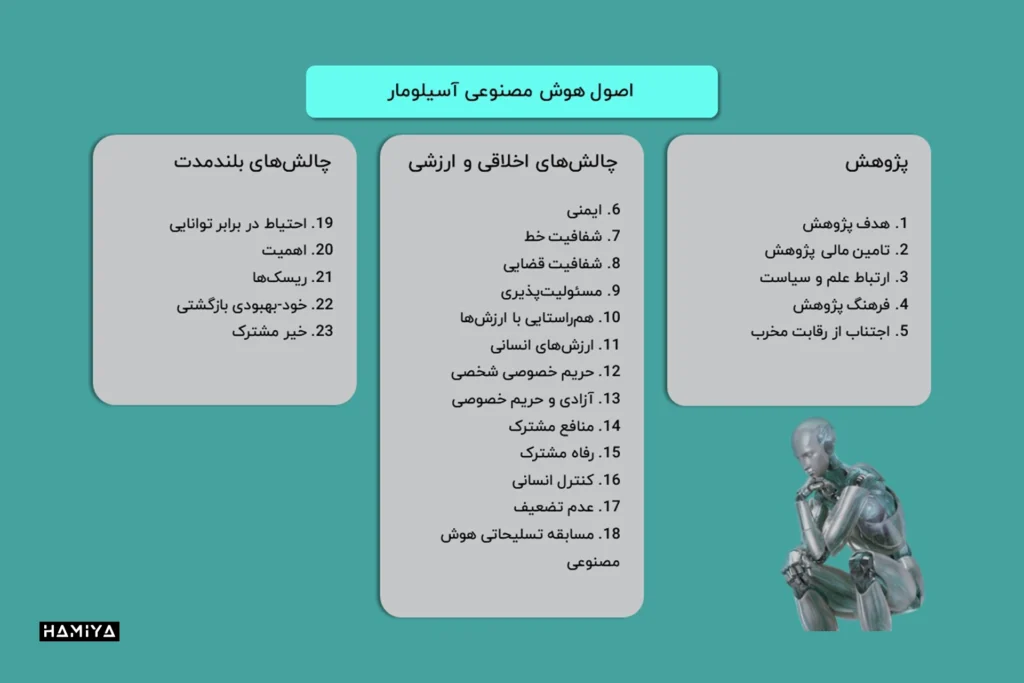

پیشرفت سریع هوش مصنوعی در پنج الی ده سال گذشته، گروههایی از متخصصان را برای توسعهی تدابیر ایمنی به منظور محافظت در برابر خطرات احتمالی هوش مصنوعی برای انسانها ترغیب کردهاست. یکی از این گروهها، یک مؤسسهی غیرانتفاعیاست که توسط ماکس تِگمارک (کیهانشناس MIT)، جان تالین (بنیانگذار اسکایپ) و ویکتوریا کراکونا (پژوهشگر DeepMind) تأسیس شدهاست. این مؤسسه با همکاری پژوهشگران و توسعهدهندگان هوش مصنوعی و همچنین دانشمندانی از رشتههای مختلف، ۲۳ دستورالعمل را تدوین کرده که امروزه با عنوان “اصول هوش مصنوعی آسیلومار” (Asilomar AI Principles) شناخته میشوند.

کلی کومبز، مدیر Digital Lighthouse در KPMG، میگوید که هنگام توسعه یک آیین نامه اخلاقی هوش مصنوعی “ضروریاست که دستورالعملهای روشنی در مورد نحوه استقرار و نظارت مداوم بر این فناوری درج شود.” این خط مشیها باید اقداماتی را انجام دهند که از سوگیری ناخواسته در الگوریتمهای یادگیری ماشین محافظت کنند، به طور مداوم انحراف در دادهها و الگوریتمها را شناسایی کنند و هم منشأ دادهها و هم هویت کسانی که الگوریتمها را آموزش میدهند، ردیابی کنند.

چرا اخلاق هوش مصنوعی مهم است؟

هوش مصنوعی یک فناوریاست که توسط انسان برای تقلید، تقویت یا جایگزینی هوش انسانی طراحی شدهاست. این ابزارها به طور معمول برای توسعه به حجم زیادی از انواع دادهها متکی هستند. پروژههای ضعیفِ طراحی شده که بر اساس دادههای معیوب، ناکافی یا مغرضانه ساخته شدهاند، میتوانند پیامدهای ناخواسته و زیانباری داشته باشند. علاوه بر این، پیشرفت سریع در سیستمهای الگوریتمی به این معنیاست که در برخی موارد، نحوه رسیدن هوش مصنوعی به نتایج آن برای ما مشخص نیست؛ بنابراین ما اساساً برای تصمیمگیریهایی که میتوانند بر جامعه تأثیر بگذارند، به سیستمهایی متکی هستیم که نمیتوانیم آنها را توضیح دهیم.

یک چارچوب اخلاقی برای هوش مصنوعی، به این دلیل مهماست که بر روی ریسکها و مزایای ابزارهای هوش مصنوعی تمرکز میکند و خط مشیهایی برای استفاده مسئولانه از آن تعیین میکند. تعیین نظام اخلاقی و روشهای بهکارگیری مسئولانه هوش مصنوعی، مستلزم کاوش در مسائل اجتماعی کلیدی و در نهایت، تأمل در چیستی انسان از سوی این صنعت و ذینفعان آناست.

چالشهای اخلاقی هوش مصنوعی

سازمانها در استفاده از فناوری هوش مصنوعی با چندین چالش اخلاقی روبرو هستند:

- قابل توضیح بودن: وقتی سیستمهای هوش مصنوعی دچار مشکل میشوند، تیمها باید بتوانند زنجیرهی پیچیدهی الگوریتمها و فرآیندهای دادهای را ردیابی کنند تا علت مشکل را بیابند. سازمانهایی که از هوش مصنوعی استفاده میکنند، باید بتوانند دادههای ورودی، دادههای خروجی، کاری که الگوریتمهایشان انجام میدهند و دلیل انجام آن را توضیح دهند. آدام ویسنیوسکی، مدیر ارشد فناوری و یکی از بنیانگذاران شرکت AI Clearing میگوید “هوش مصنوعی باید قابل ردیابی باشد تا در صورت بروز آسیب، بتوان مسیر عملکرد آن را دنبال کرد.”

- مسئولیتپذیری: جامعه، هنوز در حال تعیین مسئولیت زمانیست که تصمیمات اتخاذ شده توسط سیستمهای مبتنی بر هوش مصنوعی، عواقب فاجعهباری از جمله از دست دادن سرمایه، سلامتی یا جان انسانها داشته باشد. مسئولیت پیامدهای تصمیمات مبتنی بر هوش مصنوعی باید در فرآیندی با مشارکت حقوقدانان، قانونگذاران و شهروندان مشخص شود. یکی از چالشهای مهم، یافتن تعادل مناسب در مواردیاست که یک سیستم هوش مصنوعی ممکناست از فعالیت انسانی که جایگزین آن میشود، ایمنتر باشد، اما همچنان مشکلاتی ایجاد کند. برای مثال، میتوان به سیستمهای رانندگی خودکار اشاره کرد که باعث تصادفات و مرگ میشوند، اما تعداد این تصادفات بسیار کمتر از تصادفات ناشی از رانندگی انسانها است.

- عدالت: در مجموعه دادههایی که شامل اطلاعات قابل شناسایی شخصی هستند، اطمینان از عدم وجود سوگیری در زمینه نژاد، جنسیت یا قومیت از اهمیت فوقالعادهای برخوردار است.

- سوءاستفاده: ممکناست از الگوریتمهای هوش مصنوعی برای اهدافی غیر از آنچه برایشان طراحی شدهاند استفاده شود. ویسنویفسکی تأکید میکند که برای کم کردن خطرها و به حداقل رساندن عواقب منفی، باید این سناریوها را از قبل در طراحی مدنظر قرار داد و تدابیر ایمنی لازم را برای جلوگیری از آنها اتخاذ کرد.

مروری بر فناوری دیپ فیک، کاربردها و روشهای شناسایی آن

مزایای هوش مصنوعی اخلاقی

پذیرش سریع هوش مصنوعی در کسبوکارها با دو روند اصلی همزمان شدهاست و در بسیاری از موارد به آنها دامن زدهاست: افزایش مشتری مداری و افزایش کنشگری اجتماعی.

کسبوکارها نه تنها برای ارائه محصولات و خدمات شخصیسازیشده، بلکه برای حفظ ارزشهای مشتریان و انجام کارهای خوب برای جامعهای که در آن فعالیت میکنند، پاداش میگیرند.

سودهیر جها (Sudhir Jha)، معاون ارشد و رئیس واحد Brighterion در Mastercard

هوش مصنوعی نقش مهمی در نحوه تعامل و درک یک برند توسط مصرفکنندگان دارد. استفاده مسئولانه از هوش مصنوعی برای اطمینان از تأثیرگذاری مثبت آن ضروریاست. جها میگوید: “به کارگیری هوش مصنوعیِ اخلاقی میتواند در حفظ کارکنان با استعداد و تضمین عملکرد روان شرکتها بسیار موثر باشد.”

آیین نامه اخلاقی هوش مصنوعی چیست؟

طبق گفته جیسون شپرد، نایب رئیس اکوسیستم درکمپانی Zededa (یک ارائه دهنده ابزار هوش مصنوعی) رویکرد پیشگیرانه برای اطمینان از هوش مصنوعی اخلاقی نیازمند رسیدگی به سه حوزه کلیدیاست.

- سیاستگذاری: این بخش شامل توسعه یک چارچوب مناسب برای استانداردسازی و ایجاد مقررات است. تلاشهایی مانند اصول هوش مصنوعی Asilomar برای شروع گفتگو ضروریاست؛ هرچند تلاشهای متعدد دیگری نیز در اروپا، ایالات متحده و جاهای دیگر در حال انجاماست. سیاستهای هوش مصنوعی اخلاقی همچنین باید به نحوه برخورد با مسائل حقوقی در صورت بروز مشکل بپردازند. شرکتها میتوانند قوانین مربوط به هوش مصنوعی را در آیین نامه های خود لحاظ کنند؛ اما کارایی این قوانین به این بستگی دارد که کارمندان به آنها پایبند باشند، که همیشه آسان نیست، به خصوص وقتی که پای پول یا اعتبار آنها در میان باشد.

- آموزش: مدیران اجرایی، دانشمندان داده، کارکنان خط مقدم و مصرف کنندگان، همگی باید سیاستها، ملاحظات کلیدی و تأثیرات منفی بالقوه هوش مصنوعی غیراخلاقی و دادههای جعلی را درک کنند. یکی از بزرگترین چالشهای استفاده از هوش مصنوعی، حفظ تعادل بین سهولت به اشتراک گذاشتن دادهها و خودکارسازی فرایندها با خطرات ناشی از افراط در این زمینههاست. شپرد میگوید: “در نهایت، تمایل مصرف کنندگان به کنترل پیشگیرانه دادههای خود و توجه به تهدیدات بالقوه ناشی از هوش مصنوعی، معادله پیچیدهایاست که بر اساس ترکیبی از رضایت آنی، ارزش، درک و ریسک بنا شدهاست.”

- فناوری: مدیران اجرایی همچنین باید سیستمهای هوش مصنوعی را برای شناسایی خودکار دادههای جعلی و رفتار غیر اخلاقی طراحی کنند. این امر، نه تنها نیازمند بررسیِ هوش مصنوعی شرکت خود، بلکه بررسی تامین کنندگان و شرکا برای استفاده مخرب از هوش مصنوعی است. نمونههایی از این موارد شامل به کارگیری ویدیوها و متون جعلی برای تضعیف رقیب یا استفاده از هوش مصنوعی برای راه اندازی حملات سایبریِ پیچیدهاست. اهمیت این موضوع با تبدیل شدن ابزارهای هوش مصنوعی به کالای عمومی، افزایش خواهد یافت. به منظور جلوگیری از این اثرِ زنجیرهایِ بالقوه، سازمانها باید در اقدامات پیشگیرانهای سرمایهگذاری کنند که بر پایه زیرساخت هوش مصنوعی باز، شفاف و قابل اعتماد بنا شده باشند. شپرد معتقداست این امر منجر به پذیرش «بافتهای اعتماد» میشود که رویکردی سیستمی برای خودکارسازی تضمین حریم خصوصی، اطمینان از صحت دادهها و شناسایی استفاده غیراخلاقی از هوش مصنوعی ارائه میکند.

نمونههای از آیین نامه اخلاق هوش مصنوعی

یک آیین نامه اخلاقی هوش مصنوعی میتواند اصول را بیان کند و انگیزهای را برای رفتار مناسب فراهم کند. به عنوان مثال، جها از مسترکارت میگوید که در حال حاضر با اصول زیر برای کمک به توسعه آیین نامه اخلاقی هوش مصنوعی فعلی کمپانی کار میکند:

- یک سیستم هوش مصنوعی اخلاقی باید فراگیر، قابل توضیح، دارای هدف مثبت و استفاده مسئولانه از داده باشد.

- یک سیستم هوش مصنوعی فراگیر، بدون سوگیریاست و در مورد همه اقشار جامعه، به طور عادلانه کار میکند. این امر مستلزم دانش کامل از هر منبع دادهای است که برای آموزش مدلهای هوش مصنوعی استفاده میشود تا اطمینان حاصل شود که هیچ سوگیری ذاتی در آن مجموعه داده وجود ندارد. همچنین نیاز به یک حسابرسی دقیق از مدل آموزش دیده برای فیلتر کردن هر گونه ویژگی مشکل سازِ آموخته شده در این فرآیند دارد. همچنین باید مدلها به دقت کنترل شوند تا اطمینان حاصل شود که در آینده نیز هیچ گونه فسادی رخ نمیدهد.

- یک سیستم هوش مصنوعی قابل توضیح، از اقتدار مورد نیاز شرکتها برای اطمینان از استفاده اخلاقی از هوش مصنوعی حمایت میکند. اعتماد به اقدامات سیستمی که قابل توضیح نباشد، دشواراست. دستیابی به اعتماد ممکناست مستلزم نوعی مصالحه باشد؛ به این صورت که برای انتخاب الگوریتمی که قابل توضیحاست، عملکرد مدل، کمی به خطر بیفتد.

- یک سیستم هوش مصنوعی با هدف مثبت، به عنوان مثال، به دنبال کاهش تقلب، حذف ضایعات، پاداش دادن به افراد، کند کردن تغییرات اقلیمی، درمان بیماری و غیرهاست. از هر فناوری میتوان برای آسیب رساندن به دیگری استفاده کرد، اما ضروریاست که به راههایی برای محافظت از هوش مصنوعی در برابر سوءاستفاده برای اهداف بد بیاندیشیم. این چالش سختی است، اما با توجه به وسعت و مقیاس گسترده هوش مصنوعی، خطر عدم رسیدگی به این چالش و سوء استفاده از این فناوری بسیار بیشتر از هر زمان دیگری خواهد بود.

- یک سیستم هوش مصنوعی که از دادهها به طور مسئولانه استفاده میکند، به حریم خصوصی اطلاعات احترام میگذارد. دادهها برای یک سیستم هوش مصنوعی، کلیدی هستند و اغلب، دادههای بیشتر منجر به مدلهای بهتری میشوند. با این حال، در رقابت برای جمع آوری دادههای بیشتر و بیشتر، این امری حیاتیست که حقوق مردم در زمینه حریم خصوصی و شفافیت پایمال نشود. جمع آوری، مدیریت و استفاده مسئولانه از دادهها برای ایجاد یک سیستم هوش مصنوعی قابل اعتماد ضروریاست. در یک دنیای ایده آل، دادهها فقط در صورت نیاز جمع آوری میشوند، نه به طور مداوم و جزئیات دادهها باید تا حد امکان محدود باشد. به عنوان مثال، اگر یک برنامه برای ارائه پیش بینی آب و هوا که فقط به دادههای موقعیت مکانی کلی نیاز دارد، نباید مکان دقیق کاربر را جمع آوری کند و سیستم باید به طور مرتب دادههایی را که دیگر مورد نیاز نیستند حذف کند.

انقلاب اخلاقی یا آپوکالیپس؟ چرا حریم خصوصی داده های شما در خطر است؟

آینده هوش مصنوعی اخلاقی

برخی استدلال میکنند که یک آیین نامه اخلاق هوش مصنوعی میتواند به سرعت منسوخ شود و رویکرد پیشگیرانهتری برای سازگاری با حوزهای که به سرعت در حال تکاملاست، مورد نیاز است.

معضل اصلی آیین نامه اخلاقی هوش مصنوعی در ماهیت واکنشی آن نهفتهاست. ما به جای اینکه با اتخاذ رویکردی پیشگیرانه از بروز مشکلات جلوگیری کنیم، به دنبال حل آنها پس از وقوع هستیم. این امر در مورد سوگیری نیز صدق میکند، جایی که به جای طراحی سیستمهای هوش مصنوعی عاری از تعصب، به دنبال یافتن و رفع سوگیریهای موجود در آنها هستیم؛ گویی که این امر به طور کامل امکانپذیراست.

آریجیت سنگوپتا، بنیانگذار و مدیرعامل Aible (یک پلتفرم توسعه هوش مصنوعی)

رویکرد واکنشی در مقابله با سوگیری موجود در دادهها مشکلاتی به همراه دارد. به عنوان مثال، اگر زنان به طور تاریخی نرخ مناسبی از وام دریافت نکرده باشند، این موضوع به روشهای مختلف در دادهها تنیده میشود. سنگوپتا میگوید: “اگر متغیرهای مربوط به جنسیت را حذف کنید، هوش مصنوعی به سادگی متغیرهای دیگری را انتخاب میکند که به عنوان جایگزین برای جنسیت عمل میکنند.”

او معتقد است که آینده هوش مصنوعی اخلاقی باید بر تعریف عدالت و هنجارهای اجتماعی تمرکز کند. بنابراین، برای مثال، در یک بانک وامدهنده، تیم مدیریت و هوش مصنوعی باید تصمیم بگیرند که آیا میخواهند برابری در بررسی (برای مثال، نرخ برابر پردازش وام برای همه نژادها) را هدف قرار دهند یا نتایج متناسب را (نرخ موفقیت برای هر نژاد نسبتاً برابر باشد) و یا تأثیر برابر (اطمینان از اختصاص مبلغ متناسبی از وام به هر نژاد). سنگوپتا استدلال میکند که تمرکز باید بر روی یک اصل هدایتگر باشد تا چیزی که باید از آن اجتناب شود.

اکثر مردم موافقند که آموزش اصول راهنما به کودکان، آسانتر و موثرتر از لیست کردن تمام تصمیمات احتمالی است که ممکناست با آنها مواجه شوند.

این رویکردیست که ما در قبالِ اخلاق هوش مصنوعی در پیش گرفتهایم. ما به جای اینکه اصول راهنما را در هوشمصنوعیها قرار دهیم و به آنها اجازه دهیم خودشان آنها را بفهمند، همه کارهایی که آنها میتواند و نمیتواند انجام دهند را به آنان دیکته میکنیم.

آریجیت سنگوپتا، بنیانگذار و مدیرعامل Aible

در حال حاضر، ما برای توسعه قوانین و فناوریهایی که هوش مصنوعی مسئولانه را ترویج میکنند، باید به انسانها و عقل تاریخی آنها روی بیاوریم. شپرد میگوید که این شامل برنامهریزی محصولات و پیشنهاداتیست که از منافع انسانی محافظت میکند و علیه گروههای خاصی مانند اقلیتها، افراد با نیازهای ویژه و فقرا تبعیضی قائل نمیشود.

در مسیر پیش رو، ما باید برای سوءاستفاده از هوش مصنوعی توسط افراد شرور نیز چارهاندیشی کنیم. سیستمهای هوش مصنوعی امروزی از موتورهای قوانین کسبوکار (Business Rules Engine) تا مدلهای یادگیری ماشین که وظایف ساده را انجام میدهند، متغیر هستند. شپرد میگوید: “احتمالاً ظهور هوش مصنوعیهای آگاهتر که قادر به خودکارسازی رفتارهای غیراخلاقی خود در مقیاسی باشند که کنترل آنها فراتر از تواناییهای انسان باشد، به دههها زمان نیاز دارد.” به عبارت دیگر، هوش مصنوعیها ممکناست در آینده به حدی پیشرفته شوند که بتوانند بدون دخالت انسان، اقدامات غیراخلاقی انجام دهند. این موضوع میتواند خطرات جدی برای جامعه به وجود آورد؛ زیرا انسانها ممکناست نتوانند سرعت و پیچیدگی این رفتارهای غیراخلاقی را کنترل کنند. تصور کنید هوش مصنوعی قدرتمندی برای مدیریت ترافیک در یک شهر بزرگ طراحی شدهاست. این هوش مصنوعی ممکناست تصمیم بگیرد برای کاهش زمان سفر، قوانین رانندگی را نادیده بگیرد و باعث تصادفات و تلفات جانی شود. انسانها ممکناست متوجه این رفتار غیراخلاقی نشوند تا زمانی که فاجعهای رخ دهد.

ظهور هوش مصنوعیهای باشعوری که بتوانند رفتار غیراخلاقی خود را به طور خودکار انجام دهند، چالشهای اخلاقی و حقوقی جدیدی را به وجود خواهد آورد. لازم است قوانین و مقرراتی برای نظارت بر توسعه و استفاده از این فناوریها تدوین شود. همچنین باید در مورد مسئولیت رفتار هوش مصنوعی در صورت بروز اقدامات غیراخلاقی نیز بحث و گفتگو شود.

در نهایت میتوان گفت هوش مصنوعی، پتانسیل عظیمی برای بهبود زندگی ما دارد، اما خطرات سوءاستفاده از آن نیز وجود دارد. برای اطمینان از اینکه AI و پیشروی روزافزون آن به نفع بشریت باشد، توسعه قوانین و فناوریهای مسئولانه ضروری است.