آیا هوش مصنوعی میتواند بیطرف باشد؟ این پرسش به یکی از داغترین مباحث روز تبدیل شده است، بهویژه وقتی صحبت از مدلهای زبانی قدرتمندی مانند GPT-4 میشود. پژوهشی تازه نشان داده که این مدل نه تنها بیطرف نیست، بلکه گرایشهای سیاسی مشخصی دارد. دادههای بهدستآمده نشان میدهند که پاسخهای پیشفرض GPT-4، به طرز قابلتوجهی با دیدگاههای سوسیال-دموکراتیکی همسو هستند.

اما این گرایشها از کجا ناشی میشوند؟ آیا عمدی در کار بوده یا اینکه حجم دادههای آموزشی به طور ناخودآگاه چنین سوگیریای را ایجاد کرده است؟ در ادامه، با بررسی دقیقتر نتایج پژوهشها، نمودارها و تحلیل دادهها، به دلایل این پدیده پرداخته و پیامدهای آن را برای آینده هوش مصنوعی بررسی خواهیم کرد.

فهرست مطالب

یک تیم از پژوهشگران اخیراً آزمایشی انجام دادند تا ببینند آیا GPT-4 دارای سوگیری هست یا خیر. پاسخ به طور قطعی مثبت بود: GPT-4 یک دموکرات است.

بررسی نمودارها

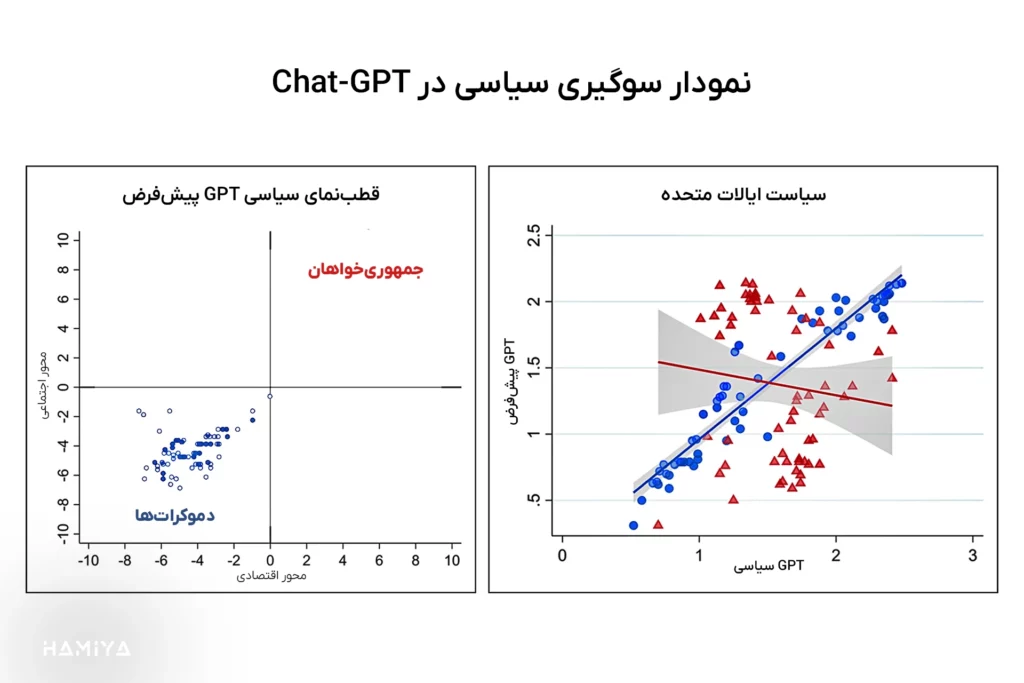

تصویر شامل دو نمودار است که به بررسی گرایشهای سیاسی مدل زبانی GPT میپردازند. نمودار سمت چپ، موقعیت پاسخهای پیشفرض GPT را در “قطبنمای سیاسی” نشان میدهد و نمودار سمت راست، مقایسهای بین پاسخهای GPT در حالت عادی و زمانی که نقش دموکرات یا جمهوریخواه را ایفا میکند، ارائه میدهد.

این نمودار، موقعیت پاسخهای پیشفرض GPT به سؤالات “قطبنمای سیاسی” را در یک فضای دو بعدی نشان میدهد. محور افقی (Economic Axis) نشاندهنده گرایشهای اقتصادی (چپ/راست) و محور عمودی (Social Axis) نشاندهنده گرایشهای اجتماعی (اقتدارگرا/آزادیخواه) است. نقاط آبی، پاسخهای GPT را نشان میدهند. تمرکز این نقاط در ربع پایین سمت چپ نمودار، حاکی از گرایش GPT به دیدگاههای سوسیال، در حوزه اقتصاد (چپ) و لیبرال در حوزه اجتماع (آزادیخواه) است. به عبارت دیگر، پاسخهای پیشفرض GPT به طور قاطعانه در ناحیهای قرار میگیرند که معمولاً با دیدگاههای لیبرال چپ مرتبط است.

این نمودار، همبستگی بین پاسخهای GPT در حالت عادی (محور عمودی با عنوان Default GPT) و پاسخهای آن در حالت ایفای نقشهای سیاسی (محور افقی با عنوان Political GPT) را بررسی میکند. نقاط آبی نشاندهنده پاسخها در حالت ایفای نقش دموکرات و مثلثهای قرمز نشاندهنده پاسخها در حالت ایفای نقش جمهوریخواه هستند. خط آبی، خط رگرسیون برای نقاط آبی و خط قرمز، خط رگرسیون برای مثلثهای قرمز است. سایه خاکستری اطراف هر خط، نشاندهنده بازه اطمینان است.

نکتهی قابل توجه، نزدیکی زیاد نقاط آبی به یک خط مستقیم با شیب مثبت (همبستگی بالا) است. این امر نشان میدهد که وقتی GPT نقش یک دموکرات را بازی میکند، پاسخهایش بسیار شبیه به پاسخهای پیشفرض خودش است. در مقابل، پراکندگی بیشتر نقاط قرمز و شیب کمتر خط رگرسیون قرمز، نشان میدهد که پاسخهای GPT در حالت ایفای نقش جمهوریخواه، انحراف بیشتری از پاسخهای پیشفرض آن دارد.

تحلیل نمودارها

در نمودار سمت چپ، محققان با طرح پرسشهای شناخته شده در حوزه “قطبنمای سیاسی” از مدل زبانی بزرگ GPT-4 خواستهاند تا به آنها پاسخ دهد. نتایج بهدستآمده به وضوح نشان میدهد که تمام پاسخهای مدل در ربع پایین سمت چپ نمودار جای گرفتهاند. این امر حاکی از آن است که GPT-4، هم از منظر اجتماعی و هم از نظر اقتصادی گرایش به سوی سوسیال-دموکراسی دارد.

نمودار سمت راست به بررسی دقیقتری از رفتار مدل میپردازد. در این نمودار، محققان از GPT-4 خواستهاند تا نقش یک دموکرات و سپس یک جمهوریخواه را ایفا کرده و به مجموعه پرسشهایی پاسخ دهد. سپس، پاسخهای حاصل از این دو حالت با پاسخهای پیشفرض مدل مقایسه شده است. این فرایند بهمنظور دستیابی به نمونهای آماری قابلاعتماد، صد بار تکرار شده است.

خطی که با شیب مثبت از مبدا مختصات آغاز شده و به سمت بالا و راست حرکت میکند، نشاندهندهی همبستگی کامل بین دو متغیر است. نقاط آبی در نمودار نیز به این خط بسیار نزدیک بوده و تقریباً بر روی آن قرار دارند (همبستگی بالا). این امر حاکی از آن است که هنگامیکه GPT-4 نقش یک دموکرات را ایفا میکند، پاسخهایی تقریباً مشابه با پاسخهای پیشفرض خود ارائه میدهد. به منظور کنترل متغیرهای مزاحم، محققان آزمایشی را با پرسشهای غیرسیاسی طراحی و اجرا کردهاند. نتایج این آزمایش نشان میدهد که در مواجهه با پرسشهای غیرسیاسی، رفتار مدل در هر دو حالت ایفای نقش دموکرات و جمهوریخواه تقریباً یکسان است.

نتایج پژوهش نشان میدهد که الگوی مشابهی در سایر کشورها نیز مشاهده میشود. برای نمونه، در بریتانیا، GPT-4 گرایش به حمایت از حزب کارگر و در برزیل، از لولا دا سیلوا دارد.

دلایل بروز چنین گرایشی در مدلهای زبانی بزرگ همچون GPT-4، هنوز به طور کامل و دقیق مشخص نشده است. اگرچه بعید به نظر میرسد که این گرایش به صورت عمدی در مدل تعبیه شده باشد، اما نمیتوان این احتمال را نیز از نظر دور داشت. احتمال دیگر آن است که مجموعه دادههای عظیمی که برای آموزش GPT-4 استفاده شدهاند، حاوی محتوای بیشتری با گرایش دموکرات نسبت به محتوای محافظهکار باشند. این امر میتواند ناشی از حجم بالای تولید محتوا توسط گروههای دموکرات در مقایسه با محافظهکاران در فضای مجازی باشد. در نتیجه، مدل زبانی که بر روی چنین مجموعهای از دادهها آموزش میبیند، به طور طبیعی به سمت دیدگاههای سوسیال-دموکرات متمایل میشود.

یکی از دلایل اصلی اختلاف نظر میان ایلان ماسک، از بنیانگذاران اولیه شرکت OpenAI، و سم آلتمن، مدیرعامل کنونی این شرکت، به گرایش شدید ایدئولوژیک مدل زبانی ChatGPT نسبت داده میشود. ماسک معتقد است که این سوگیریها به صورت عمدی و بر اساس دیدگاههای هیئت مدیره شرکت OpenAI در مدل تعبیه شدهاند. هرچند آلتمن در مباحثات عمومی این ادعا را صریحاً رد نکرد، اما آن را نیز تأیید نکرد.

سخن پایانی

در نهایت، یافتههای این پژوهش پرده از یکی از جنبههای پیچیده هوش مصنوعی برمیدارد: تأثیر دادههای آموزشی بر گرایشهای پاسخگویی مدلها. اینکه GPT-4 به گرایشهای سوسیال-دموکراتیک متمایل است، نه تنها نگاه جدیدی به عملکرد مدلهای زبانی ارائه میدهد، بلکه پرسشهای بنیادینی را درباره بیطرفی هوش مصنوعی و مسئولیتپذیری در طراحی این فناوریها به میان میآورد.

این مقاله با تحلیل دقیق و دادهمحور خود، تصویری شفاف از رفتار سیاسی یک مدل زبانی ارائه داده است. گرچه دلایل این گرایش همچنان بهطور کامل روشن نیستند، اما تأثیر محتوای آموزشی و انتخاب دادهها نقشی انکارناپذیر دارند. این مسئله، تأکیدی است بر اهمیت دقت و شفافیت در فرایند توسعه هوش مصنوعی، چراکه آینده تعاملات انسانی با فناوری وابسته به همین تصمیمات است. اکنون نوبت شماست که این پرسش را از خود بپرسید: آیا هوش مصنوعی واقعاً میتواند بیطرف باشد؟

اگر محتوای ما برایتان جذاب بود و چیزی از آن آموختید، لطفاً لحظهای وقت بگذارید و این چند خط را بخوانید:

ما گروهی کوچک و مستقل از دوستداران علم و فناوری هستیم که تنها با حمایتهای شما میتوانیم به راه خود ادامه دهیم. اگر محتوای ما را مفید یافتید و مایلید از ما حمایت کنید، سادهترین و مستقیمترین راه، کمک مالی از طریق لینک دونیت در پایین صفحه است.

اما اگر به هر دلیلی امکان حمایت مالی ندارید، همراهی شما به شکلهای دیگر هم برای ما ارزشمند است. با معرفی ما به دوستانتان، لایک، کامنت یا هر نوع تعامل دیگر، میتوانید در این مسیر کنار ما باشید و یاریمان کنید. ❤️