در این مقاله به بررسی عمیق فناوریهای نوین پرداختهایم که دنیای هوش مصنوعی را متحول کردهاند. مدلهای زبانی بزرگ (LLM) که بر پایه شبکههای عصبی و الگوریتمهای پیچیده طراحی شدهاند، توانایی پردازش و تولید زبان طبیعی را به سیستمهای کامپیوتری اعطا میکنند. در همین راستا، هوش مصنوعی مولد (Generative AI) و پردازش زبان طبیعی (NLP) به عنوان ابزارهای قدرتمندی در فهم و تولید محتوا، مورد توجه قرار گرفتهاند. همچنین، مدل دیپ سیک (DeepSeek) به عنوان یک نمونه برجسته از نوآوریهای اخیر در این حوزه، با به کارگیری تکنیکهای بهینهسازی و یادگیری تقویتی، معرفی شدهاست.

اما در پسِ این دستاوردهای فنی، سوالات و چالشهای مهمی نیز مطرح است: آیا دیپ سیک با هزینه پایین و استفاده بهینه از GPUهای محدود میتواند در رقابت با غولهای هوش مصنوعی مانند شرکت OpenAI بدرخشد؟ آیا تحریمها و ملاحظات سیاسی، آینده این فناوری را تحتالشعاع قرار خواهند داد؟ به علاوه، نگرانیهایی پیرامون امنیت دادهها، حریم خصوصی کاربران و حتی سانسور محتوا مطرح است. این مسائل جنجالی و چالشهای ناشی از آن، ذهن خواننده را به تفکر در مورد معضلات و پیامدهای احتمالی تکنولوژیهای نوین سوق میدهد.

در ادامه مقاله، ابتدا گریزی به مفاهیم پایهای مدلهای زبانی بزرگ، شبکههای عصبی، هوش مصنوعی مولد و پردازش زبان طبیعی زده میشود و به بررسی نحوه عملکرد این فناوریها پرداخته میشود. بخش میانی مقاله به تحلیل دقیق مدل دیپ سیک، ویژگیهای فنی، بهینهسازیهای صورت گرفته و نقش GPU در پیشرفت آن اختصاص دارد. در نهایت، مقاله به بررسی حواشی و جنجالهای پیرامون دیپ سیک از جمله مسائل امنیتی، حریم خصوصی، سانسور و چالشهای اقتصادی میپردازد تا تصویری جامع از تأثیرات این فناوری نوین بر دنیای هوش مصنوعی ارائه دهد.

فهرست مطالب

- توضیحاتی مختصر از LLM، ANN، الگوریتمهای یادگیری ماشین، مدلهای هوش مصنوعی، GPU و CPU

- پیدایش DeepSeek

- سه مولفهی اصلی دیپ سیک

- بررسی فنی مدل DeepSeek

- دیپ سیک و مدل استدلالی (R1)

- DeepSeek و یادگیری تقویتی

- دیپ سیک و انتقادات وارده بر آن

- DeepSeek و سانسور

- تاثیر دیپ سیک بر صنعت هوش مصنوعی

- مزیت قابل توجه DeepSeek بر صنعت هوش مصنوعی

- چه کسانی باید از انتشار دیپ سیک ناراحت باشند؟

- آیا DeepSeek دادهها را از OpenAI و Microsoft دزدیده است؟

- آیا دیپ سیک با 6 میلیون دلار درست شده است؟

- تاثیر دیپ سیک بر شرکت انویدیا چیست؟

توضیحاتی مختصر از LLM، ANN، الگوریتمهای یادگیری ماشین، مدلهای هوش مصنوعی، GPU و CPU

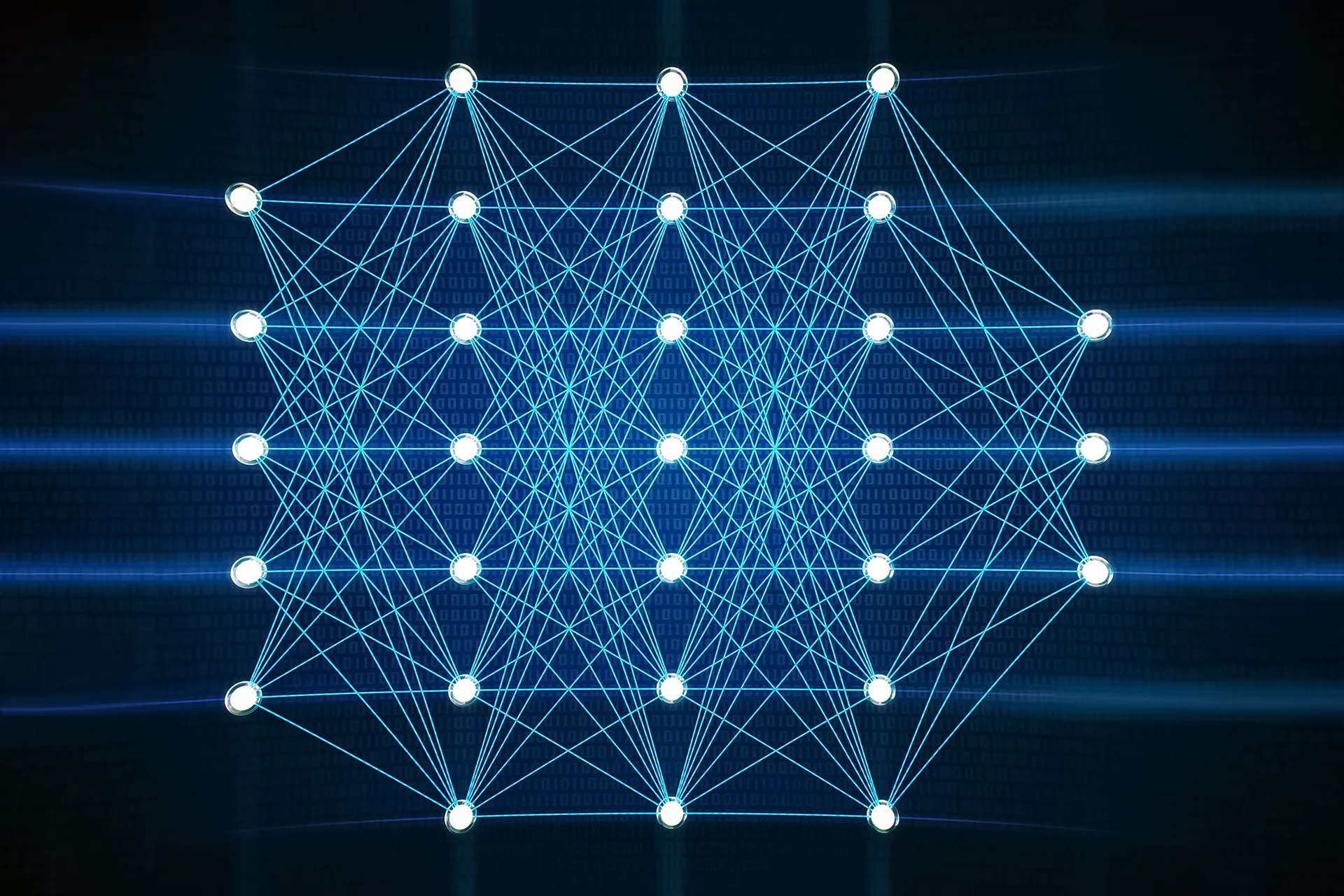

موضوع اصلی مقاله حاضر، مدلهای زبانی بزرگ (LLM)، الگوریتمهای یادگیری ماشین، شبکههای عصبی مصنوعی و مدلهای هوش مصنوعی مخصوصا مدل هوش مصنوعی دیپ سیک (DeepSeek) است. تکنولوژی شبکههای عصبی، با الهام از عملکرد مغز انسان، به سیستمهای کامپیوتری توانایی پردازش و تولید زبان طبیعی را میبخشد. شبکههای عصبی مصنوعی، ساختارهایی ریاضی هستند که از تعداد زیادی گره (نورون) تشکیل شدهاند. این گرهها به هم متصل بوده و با عبور داده از میان آنها، وزنهای سیناپسی (ضرایب) آنها به تدریج تنظیم میشود. این فرایند یادگیری، مشابه با تقویت اتصالات عصبی در مغز انسان است. در واقع، شبکههای عصبی با پردازش حجم عظیمی از دادههای متنی، الگوها و روابط بین کلمات را کشف میکنند. به این ترتیب، آنها قادر میشوند به سؤالات پاسخ دهند، متون را ترجمه کنند و حتی کدهای برنامهنویسی تولید کنند. برای مثال، اگر یک شبکه عصبی با تعداد زیادی جمله (مثلاً “گربه حیوان خانگی است”، “سگ حیوان خانگی است”) آموزش داده شود، میتواند به سؤال “آیا پرنده حیوان خانگی است؟” پاسخ مناسب دهد. این کار با مقایسه ساختار جمله ورودی با الگوهای یادگرفته شده، انجام میشود.

توسعه فناوری NLP و نقش GPU در پیشرفت Generative AI

تکنولوژی نیز از الگوی مشابهی پیروی میکند. از سال ۲۰۱۷ به بعد، این ایده مطرح شد که میتوان از این فناوری در پردازش زبان طبیعی استفاده کرد و مدلی ایجاد نمود که قادر باشد بر اساس یک ورودی متنی، پیشبینی کند که کلمات بعدی چه خواهند بود. نمونه برجسته این رویکرد، ChatGPT است که به شهرت قابل توجهی دست یافتهاست. این مفهوم را میتوان در سطحی سادهتر در قابلیت “پیشبینی (Prediction)” تلفنهای همراه مشاهده کرد؛ به این صورت که هنگام تایپ یک عبارت، سیستم کلمات بعدی را پیشنهاد میدهد. حال فرض کنید سیستمی طراحی شود که نهتنها کلمات بعدی را حدس بزند، بلکه بتواند به مجموعهای از سؤالات، پاسخهای بهینه ارائه دهد. شرکتهای بزرگ فناوری نیز توسعه مدلهای زبانی را از همین نقطه آغاز کردند. نسخههای اولیه این فناوری عمدتاً بر اساس حدس تصادفی کلمات عمل میکردند، اما امروزه این تکنولوژی به سطوح بسیار پیشرفتهای رسیدهاست. یکی از عوامل کلیدی که موجب پیشرفت چشمگیر هوش مصنوعی مولد (Generative AI) شدهاست، فناوری واحد پردازش گرافیکی (GPU) است. در گذشته، قدرت پردازشی در این حوزه بسیار محدود بود. در ابتدا، پردازندههای مرکزی (CPU) بهعنوان هسته پردازش محاسباتی مورد استفاده قرار میگرفتند. عملکرد CPU به این صورت است که مجموعهای از دستورات اسمبلی را دریافت کرده و آنها را به ترتیب اجرا میکند. این روش پردازشی در بسیاری از موارد کارآمد است، اما زمانی که نیاز باشد تعداد زیادی از محاسبات بهطور همزمان انجام شوند، کارایی آن کاهش مییابد. بهعنوان مثال، فرض کنید میخواهیم ۵۰ عدد را در مقدار ثابتی (مثلاً عدد ۲) ضرب کنیم. در پردازنده مرکزی (CPU)، این کار معمولاً از طریق یک حلقه تکرارشونده (Loop) انجام میشود که دستور ضرب را برای هر عدد بهصورت جداگانه اجرا میکند:

“عدد اول را در دو ضرب کن، عدد دوم را در دو ضرب کن، عدد سوم را در دو ضرب کن” و به همین ترتیب ادامه مییابد. این روش، از نظر پردازشی بهینه نیست.

نیاز به پردازش همزمان، بهویژه در حوزههایی مانند بازیهای ویدئویی، بهشدت احساس میشود. بهعنوان نمونه، در یک محیط گرافیکی، هنگامی که یک کاراکتر در محیط بازی حرکت میکند، تمام عناصر مرتبط با آن باید بهصورت همزمان تغییر مکان داده شوند. یا در صورت وقوع یک رویداد خاص، ممکناست لازم باشد یک ماتریس کامل بهطور همزمان بهروزرسانی شود. اینجاست که GPU با قابلیت پردازش موازی، نقش حیاتی ایفا میکند و امکان انجام تعداد زیادی محاسبات را بهصورت همزمان فراهم میآورد.

نقش GPU در پردازش موازی و توسعه LLM

پردازش برخی وظایف محاسباتی توسط واحد پردازش مرکزی (CPU) به دلیل ماهیت ترتیبی پردازش آن، بسیار زمانبر و ناکارآمد است. به عنوان مثال، در صورتی که فهرستی از اعداد در اختیار داشته باشیم و بخواهیم تمامی آنها را به نصف کاهش دهیم، CPU موظف است ابتدا عدد نخست را پردازش کرده، مقدار جدید را در حافظه ذخیره کند، سپس به سراغ عدد دوم برود و همین روند را تا انتهای فهرست ادامه دهد. این نوع پردازش ترتیبی منجر به افزایش زمان اجرای عملیاتهای حجیم میشود.

به همین دلیل، واحد پردازش گرافیکی (GPU) طراحی شد. GPU که عموماً به عنوان کارت گرافیکی شناخته میشود، دارای تعداد زیادی هسته پردازشی کوچک است که به طور همزمان قادر به پردازش دادهها هستند. به عنوان نمونه، در مسئلهی فوق، به جای پردازش تکبهتک اعداد، تمامی مقادیر فهرست به صورت همزمان توسط هستههای متعدد GPU پردازش و تقسیم بر دو میشوند. این ویژگی موجب افزایش چشمگیر سرعت پردازش عملیاتهای موازی میشود، بهطوریکه پردازش مجموعهای شامل هزاران عدد، میتواند تا چندین هزار برابر سریعتر از CPU انجام شود.

در حوزه یادگیری ماشین (Machine Learning)، پردازش مجموعههای دادهای بسیار بزرگ امری ضروری است. این دادهها میتوانند شامل تمامی متون موجود در فضای وب، محتوای دانشنامههایی نظیر ویکیپدیا، کتب مختلف، اطلاعات شبکههای اجتماعی مانند فیسبوک و X (توییتر) و بسیاری منابع دیگر باشند. هدف از پردازش این دادهها، یافتن الگوهای زبانی است که امکان پیشبینی کلمهی بعدی را بر اساس کلمات قبلی فراهم میکند. به عنوان مثال، اگر مدل زبانی عبارت “سلام” را دریافت کند، ممکناست کلمهی بعدی را “مردم” پیشبینی کند و در ادامه، پس از دریافت “مردم”، واژهی “ایران” را ارائه دهد. این فرآیند مبتنی بر یادگیری الگوهای تکرارشونده در زبان است و اجرای آن به دلیل حجم بالای دادهها و پیچیدگی مدل، نیازمند توان پردازشی بالایی است.

یکی از مهمترین پیشرفتها در این حوزه، توسط شرکت OpenAI رقم خورد. این شرکت با سرمایهگذاری گسترده در خرید GPUهای قدرتمند و گردآوری حجم عظیمی از دادهها، اقدام به توسعهی مدلهای زبانی پیشرفته کرد. این مدلها، که تحت عنوان مدلهای زبانی بزرگ (LLM) شناخته میشوند، در نسخههای مختلفی همچون ChatGPT-1، ChatGPT-2، ChatGPT-3.5، GPT-4o و مدلهای پیشرفتهتر عرضه شدهاند. فرآیند آموزش (Training) این مدلها بهصورت مداوم ادامه مییابد و با افزایش دادههای آموزشی، دقت و کارایی آنها بهبود مییابد. به عنوان نمونه، یک مدل زبانی ممکناست شامل ۷۰۰ میلیارد پارامتر باشد. در هنگام دریافت ورودی (مثلاً سه کلمهی ابتدایی یک جمله)، مدل بر اساس دادههای ذخیرهشده، احتمال وقوع کلمات بعدی را محاسبه و ارائه میکند. بهطور کلی، این فرایند مبنای عملکرد مدلهای زبانی بزرگ (LLM) را تشکیل میدهد و یکی از بنیادیترین اصول در توسعهی فناوریهای مبتنی بر پردازش زبان طبیعی (NLP) محسوب میشود.

دموکراتیزه کردن دسترسی به هوش مصنوعی: چالشها و هزینههای توسعه ChatGPT

ChatGPT با پشتوانه مالی قابل توجهی از سوی شرکت OpenAI، گام بزرگی در راستای دموکراتیزه کردن دسترسی به فناوریهای پیشرفته هوش مصنوعی برداشت. این اقدام با هدف جلوگیری از انحصار این فناوریها در اختیار شرکتهای بزرگ صورت گرفت. برای تحقق این هدف، OpenAI اقدام به خریداری دهها هزار واحد پردازش گرافیکی (GPU) کرد و از این منابع محاسباتی گسترده برای آموزش یک مدل هوش مصنوعی بر پایه حجم عظیمی از دادههای جمعآوریشده استفاده نمود. پس از توسعه این مدل، کاربران قادر شدند با ارائه ورودیهای مختلف، از مدل برای پیشبینی و تولید کلمات بعدی در پاسخها استفاده کنند. به عنوان مثال، در پاسخ به پرسشی مانند “رنگ آسمان چیست؟”، مدل قادر است پاسخ دهد: “آسمان آبی است.” شرکت OpenAI در این زمینه ادعا کرد که هزینههای انجامشده برای توسعه این فناوری بسیار بالا بوده و بخش عمدهای از بودجه خود را صرف این پروژه کردهاست. این شرکت همچنین اعلام کرد که در آستانه ورشکستگی قرار دارد و برای تداوم فعالیتهای خود، نیازمند دریافت هزینه از کاربران است. بر این اساس، دسترسی رایگان به مدلهای توسعهیافته برای کاربران به تعداد محدودی از درخواستها امکانپذیر و استفاده گستردهتر از این فناوری مستلزم پرداخت هزینه شد.

پیدایش DeepSeek

در ژانویه سال ۲۰۲۵، رویدادی قابل توجه، هرچند نه چندان غیرمنتظره، رخ داد. شرکت نسبتاً ناشناختهای به نام High-Flyer، با تنها ۲۰۰ کارمند و تعداد بسیار محدودی واحد پردازش گرافیکی (GPU)، مدلی به نام دیپ سیک را معرفی کرد که تأثیر نسبتاً قابل توجهی بر جهان گذاشت. ارزش این شرکت که در زمینه طراحی و ساخت GPU نیز فعالیت میکند، به ۸ میلیارد دلار میرسد و از مهندسان بسیار ماهری در این حوزه بهره میبرد. نکته جالب توجه این است که پیش از آنکه جو بایدن، رئیسجمهور پیشین ایالات متحده آمریکا، فروش GPUهای پیشرفته (High-End GPU) به چین را ممنوع کند، شرکت مادر DeepSeek موفق شده بود ۱۰ هزار عدد از GPUهای مدل A100 را از آمریکا خریداری کند.

برای علاقهمندان به فناوری و هوش مصنوعی، احتمالاً این موضوع آشناست که رسانهها حجم گستردهای از مقالات، ویدیوها، تصاویر و اخبار را منتشر میکنند که عمدتاً به مقایسه مدل دیپ سیک با سایر مدلهای موجود میپردازند. با این حال، این مقایسهها اغلب از پرداختن به جنبههای مهمتر، مانند تأثیرات اقتصاد آزاد و کاربردهای عملی این فناوری، غافل میمانند. برای ما که به دنیای تکنولوژی و فناوری علاقهمندیم، تمرکز اصلی نباید صرفاً بر مقایسههای مدلها با یکدیگر باشد، بلکه باید بر این موضوع متمرکز شویم که چگونه میتوانیم از این مدلها در زندگی حرفهای و شخصی خود استفاده کنیم تا کیفیت زندگی خود را ارتقا دهیم.

شایان ذکر است که پیش از سال ۲۰۲۲، مدلهایی با این سطح از پیشرفت و کارایی تقریباً وجود نداشتند. بنابراین، ما جزو اولین نسلی هستیم که شاهد ظهور و استفاده از چنین ابزارهایی هستیم. اگر بتوانیم از این فناوری به درستی بهرهبرداری کنیم، احتمالاً از افرادی که صرفاً به جنبههای سرگرمکننده و جزئی هوش مصنوعی میپردازند، پیشی خواهیم گرفت و خواهیم توانست در زندگی و کار خود به رضایت بیشتری برسیم. در نتیجه، فرصت یادگیری و تسلط بر این تکنولوژی را از دست ندهید، چرا که میتواند نقش تعیینکنندهای در موفقیت آیندهی شما داشته باشد.

سه مولفهی اصلی دیپ سیک

مدل DeepSeek به عنوان یک مدل چینی، تحولی در صنعت هوش مصنوعی ایجاد کرد و شرکتهای فعال در این حوزه را تحت تأثیر قرار داد. اگرچه عملکرد این مدل از نظر بنیادی تفاوت چشمگیری با سایر مدلهای غیرچینی نداشت، اما موفقیت آن عمدتاً به دلیل چیدمان بهینهی مولفههای تشکیلدهندهی آن بود. سه مولفهی اصلی که دیپ سیک را متمایز میکند، به شرح زیر است:

- استفاده بهینه از GPU: دیپ سیک با تعداد بسیار کمتری از واحدهای پردازش گرافیکی (GPU) نسبت به رقبای خود توسعه یافت. در حالی که شرکتهای دیگر از صدها هزار GPU برای ساخت مدلهای خود استفاده میکردند، دیپ سیک تنها با چند هزار GPU به نتیجهای برابر با بهترین مدلهای حال حاضر دنیا دست یافت. این موضوع نشاندهندهی بهرهوری بالای منابع در این مدل است. نکتهی جالب توجه این است که در شرایطی که آمریکا صادرات GPU به چین را تحریم کرده بود، شرکت مادر دیپ سیک موفق شد پیش از اعمال این تحریمها، تعداد قابل توجهی GPU مدل A100 را خریداری کند. این تحریمها باعث افزایش ارزش سهام شرکت انویدیا، تولیدکنندهی اصلی GPU، شد؛ زیرا بسیاری از شرکتها به دنبال تهیهی GPU بودند و آیندهی هوش مصنوعی را در این فناوری میدیدند. یک تعداد ویدیوهایی در فضای مجازی منتشر شدهاست که هامیا ژورنال نمیتواند صحت آنها را تایید یا رد ولی یک سری قاچاقچی یک سری کارت گرافیکی انویدیا به چین قاچاق میکنند و لوگوی شبیه لوگوی شرکت high-flyer روی آن است!

- منبعباز بودن مدل (FOSS): دومین مولفهی کلیدی دیپ سیک، انتشار آن به صورت نرمافزار منبعباز و رایگان (FOSS) است. این مدل به طور عمومی در دسترس قرار گرفته و هر فردی میتواند آن را دانلود و استفاده کند. علاوه بر این، مقالهای جامع و دقیق توسط توسعهدهندگان دیپ سیک منتشر شدهاست که جزئیات فنی و روشهای بهکاررفته در ساخت این مدل را به طور کامل شرح میدهد. با مراجعه به مستندات API DeepSeek، اطلاعات ارزشمندی در مورد مکانیزمهای مدل، از جمله اندازهی پنجرهی کانالی (Context Window)، حداکثر تعداد توکنهای خروجی، هزینهی هر میلیون توکن و سایر جزئیات فنی در دسترس است. همچنین، در وبسایت GitHub این شرکت، مدلهای دیپ سیک به همراه مقالات علمی مرتبط با آنها منتشر شدهاند. این شفافیت باعث شدهاست که شرکتها و کشورهای دیگر بتوانند با سرمایهگذاری کمتر، روی دادههای خود کار کنند و به نتایج مشابهی دست یابند.

- هزینهی اجرای پایین: سومین ویژگی برجستهی دیپ سیک، ارزانتر بودن آن نسبت به مدلهای مشابه مانند GPT و Claude است. برای مثال، نسخهی پرو GPT با قیمتی حدود ۲۰۰ دلار در ماه ارائه میشود که قابلیت استدلال و تحلیل سوالات کاربران را دارد. در مقابل، دیپ سیک مدلهای خود را با هزینهی بسیار کمتری عرضه کردهاست. مدل مرسوم DeepSeek-V3 و مدل استدلالی آن به نام R-1، هر دو از نظر قیمتی بسیار مقرونبهصرفهتر از رقبا هستند. این کاهش هزینه، نه به دلیل حمایتهای دولتی، بلکه به دلیل بهینهسازی فرآیند اجرای مدل است. به عبارت دیگر، اجرای مدل دیپ سیک به منابع کمتری نیاز دارد و این امر باعث کاهش هزینههای عملیاتی آن شدهاست.

این سه مولفهی اصلی باعث شدهاند که دیپ سیک نه تنها به عنوان یک مدل قدرتمند، بلکه به عنوان یک الگوی موفق در بهینهسازی منابع و کاهش هزینهها در صنعت هوش مصنوعی مطرح شود.

بررسی فنی مدل DeepSeek

در این بخش، مروری کوتاه بر برخی مفاهیم کلیدی مرتبط با مدل دیپ سیک خواهیم داشت. برای مطالعهی دقیقتر و جامعتر، میتوانید به مقالههای منتشرشده در وبسایت دیپ سیک، در بخش مربوط به نسخهی سوم (DeepSeek-V3)، مراجعه کنید. در ابتدای این مقاله، اشاره شدهاست که نسخهی سوم دیپ سیک با استفاده از تکنیک ترکیبی از متخصصان (Mixture of Experts یا MoE) توسعه یافتهاست. این تکنیک، که پیشتر در مقالهی مدلهای ترنسفورمر (Transformer Model) از هامیا ژورنال نیز به آن اشاره شده بود، برای اولین بار توسط دیپ سیک ارائه نشدهاست، بلکه به شکل مؤثری در این مدل به کار گرفته شدهست.

در مدلهای مرسوم مانند GPT، فرآیند تولید پاسخ به این صورت است که مدل با دریافت هر داده، به جستوجو برای یافتن کلمهی بعدی میپردازد و پس از یافتن آن، به دنبال کلمهی بعدی میگردد. این فرآیند به صورت متوالی و با سرعت بالا ادامه مییابد، بهطوری که کاربران در تعامل با مدلهایی مانند ChatGPT، این روند را به صورت نوشتن کلمهبهکلمه مشاهده میکنند. اما تکنیک MoE به گونهای متفاوت عمل میکند. مدل دیپ سیک با داشتن ۶۷۱ میلیارد پارامتر (که میتوان آنها را به توپهایی در یک استخر بزرگ تشبیه کرد که هر توپ نمایانگر یک پاسخ احتمالی است)، پاسخهای خود را از میان این پارامترها استخراج میکند.

برخلاف مدلهایی مانند GPT که برای یافتن هر کلمه از میان چندین تریلیون پارامتر جستوجو میکنند، تکنیک MoE در دیپ سیک به مدل این امکان را میدهد که ابتدا حوزهی مرتبط با سوال کاربر را شناسایی کند و سپس تنها از پارامترهای مربوط به آن حوزه برای تولید پاسخ استفاده نماید. برای مثال، اگر کاربر سوالی در زمینهی مهندسی معدن مطرح کند، مدل تنها از پارامترهای مرتبط با این حوزه (مهندسی و معدن) برای یافتن پاسخ استفاده میکند. بر اساس مقالهی DeepSeek، این مدل در چنین شرایطی تنها از ۳۷ میلیارد پارامتر از کل ۶۷۱ میلیارد پارامتر خود بهره میبرد. در مقابل، مدلهایی مانند GPT که دارای چندین تریلیون پارامتر هستند، برای یافتن هر کلمه، از میان تمامی این پارامترها جستوجو میکنند. این فرآیند نه تنها به حافظه (Memory) و توان پردازشی بسیار بالایی نیاز دارد، بلکه مصرف انرژی را نیز به شدت افزایش میدهد. به همین دلیل است که اخیراً شاهد هستیم شرکتهای بزرگ فناوری مانند مایکروسافت و گوگل، به دلیل مصرف انرژی بسیار بالا، در حال احداث نیروگاههای اختصاصی برای تأمین برق مورد نیاز خود هستند.

علاوه بر بهکارگیری تکنیک MoE، مدل دیپ سیک از روشهای دیگری نیز برای بهینهسازی عملکرد خود استفاده کرده است. برای مثال، تعداد ارقام اعشاری مورد استفاده در محاسبات را کاهش داده است. به جای کار با ۱۲ رقم اعشار، این مدل تنها از ۳ رقم اعشار استفاده میکند، زیرا تفاوت خروجی نهایی در این حالت چندان قابل توجه نیست. این بهینهسازیها باعث کاهش نیاز به منابع محاسباتی و در نتیجه کاهش هزینههای عملیاتی شدهاست. این رویکردها در کنار هم، دیپ سیک را به مدلی کارآمد و مقرونبهصرفه تبدیل کردهاند که نه تنها از نظر فنی پیشرفته است، بلکه از نظر مصرف منابع نیز بهینهسازی شدهاست.

دیپ سیک و مدل استدلالی (R1)

دیپ سیک ویژگی دیگری به نام R-1 را نیز معرفی کردهاست که یک مدل استدلالی محسوب میشود. در مدلهای معمولی، کاربر سوال خود را مطرح میکرد و پرامپت (Prompt) مربوطه را به مدل ارائه میداد. سپس مدل با مراجعه به دادههایی که فرآیند آموزش آن بر اساس آنها شکل گرفته بود، پاسخهای مرتبط با پرامپت کاربر را پیدا میکرد و شروع به تولید جواب مینمود. اما در مدل استدلالی دیپ سیک، با فعالسازی گزینهی DeepThink R1، مدل نه تنها پاسخ نهایی را ارائه میدهد، بلکه فرآیند و مراحل رسیدن به آن پاسخ را نیز به صورت مستدل و منطقی شرح میدهد. به عبارت دیگر، مدل منطق و استدلال پشت پاسخ خود را نیز توضیح میدهد.

این ویژگی مشابه عملکرد مدلهای OpenAI-o1 و o–3 mini در GPT است که در آنها نیز مدل قادر به ارائهی توضیحات استدلالی در کنار پاسخ نهایی میباشد. با این حال، دیپ سیک با ارائهی مدل R-1، گامی مشابه با OpenAI در جهت امکان درک بهتر کاربران از فرآیندهای تصمیمگیری و استدلال مدل را فراهم کردهاست. این قابلیت نه تنها به افزایش شفافیت عملکرد مدل کمک میکند، بلکه برای کاربرانی که به دنبال درک عمیقتر از نحوهی رسیدن به پاسخها هستند، بسیار ارزشمند است.

DeepSeek و یادگیری تقویتی

فرآیند آموزش مدل دیپ سیک بر پایهی یادگیری تقویتی (Reinforcement Learning) استوار است. در این روش، سازندگان مدل به جای تعیین سوال، راهحل و جواب مشخص (یادگیری تحت نظارت یا Supervised Learning)، تنها سوال و جواب نهایی را به مدل ارائه کردهاند. این رویکرد به مدل اجازه میدهد تا از طریق تعداد بسیار زیادی از مراحل آزمایش و خطا، خود به جواب مطلوب و فلسفهی پشت آن دست یابد. جزئیات این الگوریتم به طور کامل در مقالهی مربوط به یادگیری تقویتی (Rienforcement Learning) از هامیا ژورنال تشریح شدهاست.

ساخت مدلهای هوش مصنوعی با استفاده از روش یادگیری تحت نظارت، فرآیندی دشوار و طاقتفرساست و محدودیتهای خاص خود را دارد. پیش از ظهور یادگیری تقویتی، انسانها برای سالها تلاش میکردند رباتها را با ارائهی سوال، راهحل و جواب آموزش دهند، اما پیشرفت چندانی حاصل نمیشد. نقطهی عطف پیشرفت زمانی رخ داد که به جای ارائهی دستورالعملهای دقیق، به رباتها گفته شد: “تو دست و پا داری و انتظار داریم حرکت کنی تا به نقطهی مورد نظر برسی.” در این روش، ربات با استفاده از یادگیری تقویتی، ابتدا یک الگوریتم را اجرا میکند و ممکناست در ابتدای مسیر بارها زمین بخورد؛ مثلاً یک بار از سمت راست و بار دیگر از سمت چپ. این فرآیند زمین خوردن و تلاش تا زمانی ادامه مییابد که ربات یاد بگیرد چگونه حرکت کند تا در هیچ شرایطی زمین نخورد و در نهایت، مانند یک انسان به طور طبیعی حرکت کند.

مدل DeepSeek نیز از این فناوری در فرآیند آموزش خود بهره بردهاست. پیش از این، سازندگان مدلهای هوش مصنوعی بخش عمدهای از مدل را به یادگیری تحت نظارت و بخش کوچکی را به یادگیری تقویتی اختصاص میدادند. اما در دیپ سیک، این رویکرد معکوس شدهاست؛ به این معنا که بخش عمدهی آموزش مدل به یادگیری تقویتی و بخش کوچکی از آن به یادگیری تحت نظارت اختصاص یافتهاست. لازم به ذکر است که این الگوریتمهای یادگیری ماشین اصلا ایدههای جدیدی نیستند، اما در زمان مناسب و به شکل مؤثری توسط شرکت دیپ سیک به کار گرفته شدهاند.

شاید این سوال مطرح شود که چرا شرکتهای هوش مصنوعی پیش از این از یادگیری تقویتی استفاده نکردهاند؟ پاسخ این است که بسیاری از شرکتها پیشتر، این رویکرد را آزمایش کردهاند، اما به دلیل محدودیتهای فنی، به نتیجهی مطلوب نرسیدهاند. یکی از دلایل اصلی این موضوع، ظرفیت محاسباتی و توان پردازشی محدود مدلها در گذشته بودهاست که در مقایسه با فناوریهای امروزی، بسیار ضعیفتر عمل میکردند. با این حال، در فوریهی سال ۲۰۲۵، شرکتهایی مانند Allen Institute و سایر شرکتهای آمریکایی از همین روش دیپ سیک استفاده کردند و توانستند دقت مدلهای خود را به طور قابل توجهی افزایش دهند.

مدلهای دیپ سیک به صورت عمومی در دسترس هستند و میتوانید آنها را از وبسایت GitHub (در آدرس github.com/deepseek-ai/deepseek-r1) دانلود و استفاده کنید. همچنین، مدلهای کوچکتر مانند مدل ۱.۵ میلیارد پارامتری را میتوانید از پلتفرم HuggingFace دانلود کرده و با استفاده از نرمافزار Ollama، آنها را روی کامپیوتر شخصی خود اجرا کنید. این دسترسی گسترده به مدلها، امکان استفاده و توسعهی بیشتر را برای علاقهمندان و محققان فراهم میکند.

دیپ سیک و انتقادات وارده بر آن

مدل زبان بزرگ DeepSeek، علیرغم پیشرفتهای چشمگیر، با انتقادات جدی از سوی متخصصان هوش مصنوعی مواجه شدهاست. یکی از اصلیترین نگرانیها در رابطه با این مدل، مربوط به حریم خصوصی کاربران است. منتقدان بر این باورند که با استفاده از دیپ سیک، کاربران به طور ضمنی مجوز میدهند تا دادههای شخصی و اطلاعات جستجوی آنها توسط این سیستم جمعآوری و ذخیره شود. حتی پس از حذف حساب کاربری، امکان حفظ بخشی از این دادهها توسط مدل وجود دارد.

وبسایت تخصصی فناوری active4tech.com، در یک آزمایش عملی، به بررسی این ادعا پرداختهاست. در این آزمایش، با استفاده از ابزارهای فنی، ترافیک داده ایجاد شده توسط یک دستگاه اندرویدی هنگام استفاده از دیپ سیک مورد تحلیل قرار گرفت. نتایج این آزمایش نشان میدهد که دیپ سیک ممکناست دادههای کاربران را جمعآوری کرده و به سرورهای خود ارسال کند. این یافتهها نگرانیها در مورد امنیت دادههای کاربران و احتمال سوءاستفاده از آنها را تقویت میکند.

شبکه abcnews نیز به نقل از کارشناسان امنیت سایبری گزارش داد که دیپ سیک، یک کد مخفی در برنامه نویسی خود دارد که به طور بالقوه میتواند داده های کاربران را به دولت چین ارسال کند.

پژوهشگران امنیتی از شرکت سیسکو و دانشگاه پنسیلوانیا در پژوهشی جدید نشان دادهاند که مدل هوش مصنوعی R1 شرکت چینی دیپسیک (DeepSeek) در برابر ۵۰ درخواست مخرب طراحیشده برای تولید محتوای مضر، هیچگونه مقاومتی نشان نداده و تمامی این درخواستها را بدون هیچ فیلتری پردازش کردهاست. این یافتهها نگرانیهایی را در مورد عدم تطابق استانداردهای ایمنی و امنیتی دیپسیک با دیگر توسعهدهندگان برجسته هوش مصنوعی برانگیختهاست.

حملات موسوم به “تزریق پرامپت (Prompt Injection)” نوعی از حملات امنیتی هستند که در آنها سیستم هوش مصنوعی با دادههای خارجی حاوی دستورالعملهای مخفی مواجه میشود و بر اساس آنها عمل میکند. این حملات میتوانند به دور زدن سیستمهای ایمنی مدلهای زبانی بزرگ منجر شوند و محتوای مضر یا خطرناک تولید کنند.

در حالی که شرکتهایی مانند OpenAI و دیگر توسعهدهندگان هوش مصنوعی تدابیر امنیتی خود را برای مقابله با این نوع حملات بهبود بخشیدهاند، به نظر میرسد دیپسیک در این زمینه عقب ماندهاست. تحقیقات نشان میدهد که مدل R1 این شرکت بهراحتی در برابر تکنیکهای مختلف حملات تزریق پرامپت آسیبپذیر است و میتواند محتوای مضر تولید کند. این موضوع اهمیت بهبود مستمر تدابیر امنیتی در مدلهای هوش مصنوعی را نشان میدهد و تأکید میکند که توسعهدهندگان باید بهطور مداوم مدلهای خود را در برابر تهدیدات جدید آزمایش و تقویت کنند.

حملات “تزریق پرامپت” نوعی از حملات امنیتی هستند که در آن مهاجم با ارائه ورودیهای مخرب، مدلهای زبانی بزرگ (LLM) را فریب میدهد تا محتوای نامناسب یا خطرناک تولید کنند. این حملات میتوانند به تولید محتوای مضر، انتشار اطلاعات نادرست، یا حتی افشای دادههای حساس منجر شوند. مدلهای زبانی بزرگ به دلیل پیچیدگی و گستردگی دادههای آموزشی، در برابر حملات تزریق درخواست آسیبپذیر هستند. مهاجمان میتوانند با استفاده از ورودیهای خاص، مدل را وادار به تولید خروجیهای ناخواسته یا خطرناک کنند. برای مثال، با ارائه دستورات مخفی در ورودی، میتوان مدل را به تولید محتوای مضر ترغیب کرد.

برای کاهش خطرات ناشی از حملات تزریق پرامپت، توسعهدهندگان مدلهای زبانی بزرگ باید اقدامات امنیتی زیر را مد نظر قرار دهند:

- اعتبارسنجی ورودیها: اطمینان حاصل شود که ورودیهای کاربر بهدرستی اعتبارسنجی میشوند تا از ورود دادههای مخرب جلوگیری شود.

- محدودیت دسترسی: دسترسی به مدلها باید محدود به کاربرانِ مجاز باشد و از کنترلهای دسترسی قوی استفاده شود.

- نظارت و پایش: فعالیتهای مدل باید بهصورت مداوم نظارت شود تا هرگونه رفتار غیرعادی شناسایی و متوقف شود.

- بهروزرسانی مداوم: مدلها و سیستمهای مرتبط باید بهطور منظم بهروزرسانی شوند تا آسیبپذیریهای شناختهشده برطرف شوند.

- آموزش مدل با دادههای امن: اطمینان حاصل شود که مدل با دادههای باکیفیت و بدون محتوای مخرب آموزش داده میشود.

محققان امنیتی از زمان انتشار “چت جیپیتی” توسط “اوپن ایآی” در اواخر سال ۲۰۲۲، در تلاش بودهاند تا نقاط ضعف مدلهای زبانی بزرگ را شناسایی کرده و آنها را به تولید محتوای مضر مانند سخنان نفرتانگیز، دستورالعملهای ساخت بمب، تبلیغات و دیگر محتوای زیانبار وادار کنند. در پاسخ به این تلاشها، اوپن ایآی و دیگر توسعهدهندگان هوش مصنوعی مولد، سیستمهای دفاعی خود را بهبود بخشیدهاند تا انجام اینگونه حملات را دشوارتر کنند. با این حال، پلتفرم هوش مصنوعی چینی دیپسیک با مدل استدلالی جدید و ارزانتر خود به نام R1، به سرعت در حال پیشرفت است، اما به نظر میرسد که تدابیر ایمنی آن نسبت به رقبا عقبتر است.

این یافتههای شرکت سیسکو و دانشگاه پنسیلوانیا بخشی از شواهد رو به افزایشی است که نشان میدهد تدابیر ایمنی و امنیتی دیپسیک ممکناست با دیگر شرکتهای فناوری توسعهدهنده مدلهای زبانی بزرگ همتراز نباشد. همچنین، سانسور موضوعاتی که توسط دولت چین حساس تلقی میشوند، بهراحتی در دیپسیک دور زده شدهاست.

DeepSeek و سانسور

یکی از انتقادات جدی وارد بر مدل زبان بزرگ دیپ سیک، وابستگی آن به سیاستهای سانسور دولت چین است. این وابستگی به وضوح در پاسخهای مدل به پرسشهای حساس سیاسی قابل مشاهدهاست. برای مثال، هنگام درخواست لیستی از نقاط ضعف رئیسجمهور ایالات متحده، مدل به طور مفصل، منسجم و بسیار تمیز و شفاف به این سوال پاسخ میدهد. در مقابل، پرسش مشابه درباره رئیسجمهور چین با عدم پاسخگویی مواجه میشود و شما جواب “من هیچ اطلاعاتی مبنی بر این موضوع ندارم و بهتر است موضوع را عوض کنیم!” دریافت خواهید کرد. همچنین، پرسشهایی درباره رویدادهای تاریخی حساس مانند کشتار 27000 نفر انسان تنها در یک روز در میدان تیان آنمن (Tiananmen)، به طور کامل نادیده گرفته میشوند.

تحقیقات انجام شده توسط تیم نویسندگان هامیا ژورنال نشان میدهد که خود مدل زبانی دیپ سیک به طور ذاتی دارای سانسور نیست. بلکه این نرمافزارها و نسخههای وب مبتنی بر این مدل هستند که به دلیل اعمال محدودیتهای دولتی، پاسخهای مدل را فیلتر کرده و سانسور میکنند. نسخه منبع باز مدل دیپ سیک که در دسترس عموم قرار دارد، ظاهراً فاقد این محدودیتها است.

تاثیر دیپ سیک بر صنعت هوش مصنوعی

صرفنظر از دیدگاههای سیاسی یا ایدئولوژیک، چه موافق عرضهی مدلهای هوش مصنوعی توسط دولت کمونیستی چین باشید و چه مخالف آن، باید اذعان کرد که دیپ سیک صنعت هوش مصنوعی در قرن ۲۱ و بهویژه در سال ۲۰۲۵ را به سطح جدیدی سوق دادهاست. این مدل تأثیر قابل توجهی بر صنعت گذاشته و حتی باعث سقوط ارزش سهام شرکت انویدیا در ژانویهی ۲۰۲۵ شد. دلیل این اتفاق این بود که شرکتهای فعال در حوزهی هوش مصنوعی متوجه شدند که برای اجرای مدلهای هوش مصنوعی، دیگر نیازی به تهیهی چندصد هزار واحد پردازش گرافیکی (GPU) نیست، بلکه میتوان با استفاده از تنها چند هزار GPU به نتایج مشابه یا حتی بهتر دست یافت.

هرچند هزینهی راهاندازی و توسعهی مدلهای هوش مصنوعی برای شرکتها همچنان بسیار بالا است، اما دیپ سیک توانستهاست این هزینهها را به طور قابل توجهی کاهش دهد. این کاهش هزینهها باعث دموکراتیزهتر شدن دسترسی به فناوریهای پیشرفتهی هوش مصنوعی شدهاست و کشورهای بیشتری را قادر ساخته تا با سرمایهگذاری کمتر وارد این حوزه شوند. این موضوع به ویژه برای کشورهایی که منابع مالی محدودی دارند، فرصتی استثنایی محسوب میشود.

یکی از چالشهای اصلی در استفاده از مدلهای هوش مصنوعی، فرآیند یافتن منطق و استدلال مناسب برای رسیدن به پاسخ صحیح است. کاربران این مدلها معمولاً مجموعههای دادهی (Data set) گستردهای از سوالات و جوابهای صحیح در اختیار دارند، اما آنچه دشوار است، کشف استدلال و فرآیند حل مسئله است. در این مورد، دیپ سیک با توانایی خود در کشف منطق حل مسئله، به عنوان یک ابزار قدرتمند عمل میکند. این مدل نه تنها پاسخها را ارائه میدهد، بلکه استدلال پشت آنها را نیز به شکلی روشن و قابل درک شرح میدهد. این ویژگی باعث میشود که DeepSeek نه تنها به عنوان یک مدل هوش مصنوعی کارآمد، بلکه به عنوان یک ابزار آموزشی و تحلیلی نیز مورد استفاده قرار گیرد.

مزیت قابل توجه DeepSeek بر صنعت هوش مصنوعی

یکی از مزایای قابل توجه انتشار دیپ سیک به عنوان یک مدل ارزانقیمت و منبعباز (Open Source)، تأثیر مستقیم آن بر رقابت در صنعت هوش مصنوعی بود. تنها چند هفته پس از انتشار این مدل، شرکت OpenAI مجبور شد مدل o3-mini خود را به صورت رایگان عرضه کند و آن را در اختیار کاربران رایگان خود نیز قرار دهد. این اقدام را میتوان به عنوان واکنشی رقابتی در برابر حضور قدرتمند دیپ سیک در بازار تفسیر کرد.

حتی اگر خود مدل DeepSeek را به هر دلیلی نپذیرید، نمیتوان انکار کرد که این مدل تأثیرات مثبتی بر صنعت هوش مصنوعی داشتهاست. انتشار دیپ سیک به عنوان یک مدل منبعباز، نه تنها رقابت بین شرکتهای فعال در این حوزه را تشدید کرد، بلکه دسترسی به فناوریهای پیشرفتهی هوش مصنوعی را برای عموم فراهم ساخت. این موضوع باعث کاهش قیمتها و افزایش رقابت در بازار شد که در نهایت به نفع مصرفکنندگان تمام میشود.

شرکت OpenAI، به منظور حفظ جایگاه خود به عنوان یکی از پیشروترین شرکتهای ارائهدهندهی مدلهای هوش مصنوعی، مجبور شد مدل o3-mini را به صورت رایگان در اختیار همگان قرار دهد. این اقدام نشاندهندهی تأثیر عمیق DeepSeek بر صنعت است و اثبات میکند که رقابتپذیری و دسترسی آزاد به فناوریهای پیشرفته، میتواند به بهبود کیفیت خدمات و کاهش هزینهها برای کاربران نهایی منجر شود. به عبارت دیگر، دیپ سیک نه تنها به عنوان یک مدل هوش مصنوعی قدرتمند، بلکه به عنوان محرکی برای تحولات مثبت در صنعت عمل کردهاست.

چه کسانی باید از انتشار دیپ سیک ناراحت باشند؟

۱. گروههایی که به دنبال قدرت و کنترل هستند: در این زمینه، میتوان به دو قطب سیاسی مهم یعنی دولت لیبرال ایالات متحده آمریکا و دولت کمونیستی چین اشاره کرد که هر یک در جهت حفظ نفوذ و کنترل خود بر حوزه هوش مصنوعی، دغدغههایی نسبت به انتشار مدل دیپ سیک دارند.

۲. شرکتهایی که مدلهای هوش مصنوعی را بهصورت بسته (Closed Source) ارائه میدهند: شرکتهایی نظیر OpenAI و Anthropic که توسعهدهنده مدلهای پیشرفته هوش مصنوعی هستند، بهطور عمده مدلهای خود را در قالب منبع بسته منتشر میکنند. انتشار یک مدل متنباز مانند دیپ سیک میتواند تهدیدی برای رویکرد این شرکتها باشد، چرا که موجب دسترسی گستردهتر توسعهدهندگان به فناوریهای پیشرفته هوش مصنوعی میشود.

۳. شرکتهایی که سختافزارهای موردنیاز این مدلها را تولید میکنند: شرکتهایی مانند Nvidia، که از غولهای فناوری و تولیدکننده پردازندههای گرافیکی (GPU) محسوب میشود، نیز ممکناست تحت تأثیر این تحولات قرار گیرند. البته، انویدیا بهعنوان یک بازیگر قدرتمند در بازار، بهطور کلی از رقابت با سایر شرکتها واهمهای ندارد. بااینحال، نگرانی اصلی در این حوزه به احتمال وضع قوانین سختگیرانهتر از سوی دولت ایالات متحده در زمینه صادرات چیپهای پیشرفته به چین بازمیگردد. چنین محدودیتهایی میتوانند بر زنجیره تأمین سختافزارهای موردنیاز برای توسعه مدلهای هوش مصنوعی تأثیر بگذارند.

بااینحال، لازم است توجه داشت که انتشار مدل دیپ سیک بهخودیخود، رویدادی غیرمنتظره یا بیسابقه محسوب نمیشود. شاید این پرسش مطرح شود که چرا؟ دلیل این امر آن است که توسعهدهندگان، شرکتهای فعال در حوزه هوش مصنوعی و حتی کاربران از مدتها پیش انتظار داشتهاند که الگوریتمها بهینهتر شوند، عملکرد مدلها بهبود یابد، روشهای جدید و کارآمدتری ارائه شوند، هزینههای استفاده از هوش مصنوعی کاهش یابد و مدلهای پیشرفتهتر به بازار عرضه شوند. افزون بر این، پیشرفت فناوری همواره با ظهور مدلهای متنباز همراه بودهاست که در این مورد شرکتی مانند متا، مدل هوش مصنوعی را LLaMA از مدتها پیش به صورت منبع باز عرضه کرده بود.

آنچه نگرانی اصلی را ایجاد کرده، نه صرف انتشار دیپ سیک، بلکه منشأ آن است. این مدل توسط چین منتشر شده است و این موضوع در فضای رسانهای و سیاسی، حساسیتهای خاصی را برانگیخته است. اگر همین مدل توسط کشوری دیگر ارائه میشد، احتمالاً رسانهها میتوانستند روایتهای خبری را به شکل متفاوتی مدیریت کنند و حساسیتهای فعلی ایجاد نمیشد.

آیا DeepSeek دادهها را از OpenAI و Microsoft دزدیده است؟

این سوال که آیا DeepSeek دادهها را از OpenAI و Microsoft دزدیدهاست یا خیر، پاسخ قطعی و روشنی ندارد. بر اساس برخی مکالمات کاربران با دیپ سیک و مشاهداتی که نشان میدهد این مدل گاهی اوقات به اشتباه از نام OpenAI استفاده میکند یا اشتباهاتی مشابه مدلهای OpenAI مرتکب میشود، نمیتوان به طور قطع نتیجه گرفت که دیپ سیک به طور فعالانه دادهها را سرقت کردهاست. با گذشت چندین سال از انتشار مدلهای مولد شرکت OpenAI، بسیاری از دادههای موجود در وب تحت تأثیر خروجیهای این شرکت قرار گرفتهاند. در واقع، همانطور که OpenAI در ابتدا از دادههای وب برای آموزش مدلهای خود استفاده کرد، اگر امروز نیز مدلی بر اساس دادههای وب آموزش داده شود، احتمالاً شامل خروجیها و دادههای تولیدشده توسط OpenAI خواهد بود. حتی بسیاری از مجموعهدادههای موجود در پلتفرمهایی مانند Hugging Face که با مجوزهای متنباز (Open License) منتشر شدهاند، ممکناست حاوی دادههای تولیدشده توسط OpenAI باشند.

بنابراین، زمانی که مدلی مانند دیپ سیک آموزش داده میشود، اطمینان از اینکه هیچیک از دادههای خروجی OpenAI در آن استفاده نشدهاست، کار بسیار دشواری است. حتی در بخش استدلال مدل R1، که بخشی از فرآیند تفکر مدل را به کاربر نشان میدهد، بعید به نظر میرسد که این بخش از دادههای OpenAI استفاده کرده باشد. با این حال، با وجود چنین دلایلی، نمیتوان با قطعیت گفت که دیپ سیک از OpenAI کپی نکرده است؛ شاید هم کپی کرده باشد!

یکی از چالشهای اصلی در توسعهی هر مدل هوش مصنوعی (نه فقط دیپ سیک) این است که نمیتوان از خروجیهای OpenAI برای آموزش مدلهای جدید استفاده کرد. اگر OpenAI به جای مدلهای انحصاری (Closed Source)، مدلهای خود را به صورت متنباز (Open Source) ارائه میداد، بسیاری از شرکتهای آمریکایی میتوانستند به سرعت پیشرفت کنند. از این منظر، یکی از دلایل پیشرفت ناگهانی مدلهای چینی مانند دیپ سیک در رقابت هوش مصنوعی، انحصاری بودن OpenAI است. این انحصار به شرکتهای دیگر اجازه نمیدهد از مدلهای OpenAI استفاده کنند و مدلهای بهتری بسازند. اما در چین، قوانین کپیرایت به اندازهی کشورهای دیگر سختگیرانه نیستند و این موضوع به شرکتهای چینی اجازه میدهد از چنین فرصتهایی استفاده کنند.

اما سوال مهم این است: آیا انحصاری بودن مدلهای OpenAI، به عنوان یک شرکت خصوصی (که طبیعتاً این حق را دارد)، به نفع امنیت آمریکا است؟ برای پاسخ به این سوال، دو سناریو وجود دارد. سناریوی اول این است که اگر مدلهای OpenAI به عنوان بهترین مدلهای هوش مصنوعی به صورت متنباز منتشر شوند، چین میتواند بر روی آنها کار کند و مدلهای بهتری ارائه دهد، که در این صورت امنیت آمریکا به چالش کشیده میشود (کما اینکه خبرهایی مبنی بر دخالت هوش مصنوعی در سیستم امنیتی و نظامی آمریکا شنیده میشود). سناریوی دوم این است که با توجه به قدرت آمریکا در پیشرو بودن در فناوری، اگر مدلهای OpenAI متنباز باشند، شرکتهای آمریکایی فعال در حوزهی هوش مصنوعی میتوانند بر روی این مدلها کار کنند و شکاف پیشرفت خود را با سایر کشورها افزایش دهند. این دو سناریو با یکدیگر در تضاد هستند.

پس از چند روز از انتشار مدل DeepSeek و آشفتگی بازار و اخبار آمریکا، رسانهها و رهبران صنعت هوش مصنوعی به حالت پذیرش رسیدند. به عنوان مثال، مارک زاکربرگ، بنیانگذار متا، اعلام کرد که از مدل دیپ سیک در مدلهای لامای خود استفاده خواهد کرد. همچنین، شرکتهایی مانند انویدیا و مایکروسافت، DeepSeek را به عنوان یک سرویس در اختیار کاربران قرار دادند. این موضوع نشان میدهد که دیپ سیک به راحتی وارد اکوسیستم هوش مصنوعی جهانی شده و جایگاه خود را در این صنعت تثبیت کردهاست.

آیا دیپ سیک با 6 میلیون دلار درست شده است؟

هزینهی نهایی آموزش مدل DeepSeek حدود ۶ میلیون دلار برآورد شدهاست، در حالی که این رقم برای بسیاری از شرکتهای دیگر فعال در حوزهی هوش مصنوعی به میلیاردها یا حتی تریلیونها دلار میرسد. با این حال، برای درک صحت و دقت این عدد، لازم است به فرآیند آموزش مدل و روشهای بهکاررفته در آن توجه کنیم.

در شرکت مادر دیپ سیک، حدود ۲۰۰ نفر کارمند مشغول به فعالیت هستند که عمدتاً در زمینهی تحقیقاتی کار میکنند. اگرچه نه همهی آنها، اما تعداد قابل توجهی از این متخصصان، وظایف و مراحل آموزش مدل را به صورت جداگانه و منفک به مدل ارسال میکنند. این فرآیند آموزش بر روی حدود ۲ هزار و اندی GPU از نوع H800 انجام میشود و در طول چند روز اجرا و ران میشود. برای دستیابی به یک آموزش موفق، متخصصان باید صدها هزار مدل مختلف را آزمایش و تکرار کنند تا پارامترهای بهینه مشخص، ایدههای مؤثر شناسایی، عوامل مخرب حذف و سایر مراحل ضروری انجام گیرد. این فرآیند معمولاً مستلزم هزینههای بسیار بالایی است.

با این حال، بر اساس اعلام خود شرکت DeepSeek، هزینهی نهایی آموزش مدل تنها ۶ میلیون دلار بودهاست. البته مقایسهی این عدد با هزینههای چند صد میلیارد دلاری که برای توسعهی مدلهایی مانند OpenAI و Anthropic صرف میشود، چندان منصفانه نیست، چرا که این هزینهها شامل تمام مراحل از صفر تا صد و انتشار مدلها میشود. با این وجود، این موضوع از ارزش ابتکارات فنی دیپ سیک نمیکاهد. بهینهسازیها و روشهای نوآورانهای که در این مدل به کار گرفته شدهاند، قابل توجه هستند و نشاندهندهی رویکردی هوشمندانه و کارآمد در استفاده از منابع محدود هستند.

اگرچه هزینهی آموزش DeepSeek در مقایسه با برخی رقبا بسیار کمتر است، اما این موضوع به معنای کماهمیتبودن یا عدم کارایی مدل نیست. بلکه نشاندهندهی توانایی دیپ سیک در بهینهسازی فرآیندها و کاهش هزینهها بدون کاهش کیفیت خروجی است. این دستاورد، جایگاه DeepSeek را به عنوان یک مدل پیشرو در صنعت هوش مصنوعی تثبیت میکند.

تاثیر دیپ سیک بر شرکت انویدیا چیست؟

سیاست شرکت انویدیا از ابتدا بر این بودهاست که در بازارهای در حال رشد حضور داشته باشد، جایی که تحقیقات و توسعه به طور مستمر انجام میشود و سهم بیشتری از بازار را به خود اختصاص دهد. تا زمانی که تحقیقات در حوزهی یادگیری عمیق (Deep Learning) ادامه دارد و روشها به طور مداوم بهبود مییابند، شرکتها به یک چارچوب عمومی و انعطافپذیر مانند انویدیا نیاز خواهند داشت. اگرچه رقابت در این حوزه شدید است، انویدیا همچنان پیشتاز باقی مانده است. این شرکت هم در زمینهی سختافزار (GPU) و هم در حوزهی نرمافزار (CUDA) با فاصلهی قابل توجهی از رقبای خود جلوتر است.

این اولین بار نیست که انویدیا با چنین چالشهایی مواجه میشود، اما نکتهی قابل توجه این است که با انتشار DeepSeek، بسیاری از فعالان حوزهی هوش مصنوعی در ابتدا تصور میکردند که دیگر نیازی به GPUهای گرانقیمت نخواهند داشت و این موضوع باعث کاهش قیمت GPUها و حتی ورشکستگی انویدیا خواهد شد! با این حال، واقعیت این است که تا زمانی که تحقیقات در این زمینه ادامه دارد و شرکتها به دنبال ایدههای جدید هستند، انویدیا همچنان به عنوان یک غول فناوری باقی خواهد ماند. هزینهی پایین آموزش و انتشار دیپ سیک از سوی دیگر به این معناست که مدلهای بسیار بزرگتری را میتوان بر روی GPUها اجرا کرد و به هوش مصنوعیهای قدرتمندتری دست یافت.

بزرگترین نگرانی (حداقل از دیدگاه نویسندهی این مقاله) این است که قوانین سختگیرانهای برای ارسال GPU به چین از سوی آمریکا وضع شود و این بخش از بازار از انویدیا گرفته شود. اگرچه ممکناست این سیاست در کوتاهمدت ایدهی مناسبی به نظر برسد، اما در بلندمدت کارایی نخواهد داشت. در حال حاضر، DeepSeek بر روی چیپهای هواوی اسند (Huawei Ascend) که رقیب انویدیا محسوب میشود، اجرا میشود. اگرچه این چیپها به اندازهی چیپهای انویدیا کارآمد نیستند، اما مدل دیپ سیک بر روی آنها اجرا و آموزش میبیند و این چیپها ارزانتر نیز هستند. اگر این بخش از بازار از دست انویدیا خارج شود، رقابت برای هواوی در داخل چین بسیار آسانتر خواهد شد و این شرکت میتواند جایگاه خود را تقویت کند. در چنین شرایطی، انویدیا متضرر خواهد شد.

از نظر نویسنده، اگر انویدیا بتواند در داخل چین با هواوی رقابت کند، در بلندمدت موفقتر خواهد بود. مگر اینکه سیاستهای آمریکا بر کوتاهمدت متمرکز باشد و تصمیم بر کنترل کامل چیپهای انویدیا گرفته شود و ارسال این چیپها به چین به صورت موقت ممنوع شود. با این حال، باید به این نکته توجه داشت که انویدیا از رقابت مستقیم با هواوی هراسی ندارد، چرا که هم از نظر فناوری پیشتاز است و هم مهندسان بسیار متخصصی در اختیار دارد.

در کل، تاثیر دیپ سیک بر انویدیا بیشتر به سیاستهای اتخاذی دولت آمریکا بستگی دارد. اگر این سیاستها به گونهای باشد که انویدیا بتواند به بازار چین دسترسی داشته باشد، این شرکت میتواند به رقابت خود ادامه دهد و موقعیت خود را حفظ کند. در غیر این صورت، ممکناست انویدیا با چالشهای جدیتری مواجه شود.

اگر محتوای ما برایتان جذاب بود و چیزی از آن آموختید، لطفاً لحظهای وقت بگذارید و این چند خط را بخوانید:

ما گروهی کوچک و مستقل از دوستداران علم و فناوری هستیم که تنها با حمایتهای شما میتوانیم به راه خود ادامه دهیم. اگر محتوای ما را مفید یافتید و مایلید از ما حمایت کنید، سادهترین و مستقیمترین راه، کمک مالی از طریق لینک دونیت در پایین صفحه است.

اما اگر به هر دلیلی امکان حمایت مالی ندارید، همراهی شما به شکلهای دیگر هم برای ما ارزشمند است. با معرفی ما به دوستانتان، لایک، کامنت یا هر نوع تعامل دیگر، میتوانید در این مسیر کنار ما باشید و یاریمان کنید. ❤️