هامیا ژورنال، به عنوان یکی از معتبرترین مراجع تخصصی در حوزه فناوری، تکنولوژی و هوش مصنوعی، همواره تلاش کرده است تا جدیدترین و کاربردیترین مطالب این حوزه را در اختیار علاقهمندان قرار دهد. مقاله پیش رو با عنوان “هوش مصنوعی جعبه سیاه” یکی از تخصصیترین مباحث دنیای هوش مصنوعی را مورد بررسی قرار میدهد. برای درک عمیق این مقاله، خواننده نیازمند آشنایی با مفاهیمی همچون شبکههای عصبی مصنوعی، یادگیری ماشین، یادگیری عمیق و مسائلی از این قبیل است که خوشبختانه تمامی این موضوعات پیشتر در مقالات متعدد هامیا ژورنال به تفصیل مورد بحث قرار گرفتهاند.

هوش مصنوعی جعبه سیاه، مفهومی پیچیده و در عین حال جذاب در دنیای هوش مصنوعی است. تصور کنید سیستمی که میتواند تصمیمات بسیار دقیق و پیچیده بگیرد، اما نمیتواند توضیح دهد که چگونه به این تصمیمات رسیده است. این موضوع سؤالات متعددی را در ذهن ایجاد میکند: آیا میتوان به چنین سیستمی اعتماد کرد؟ چگونه میتوان از عملکرد صحیح آن اطمینان حاصل کرد؟ و مهمتر از همه، آیا استفاده از چنین سیستمهایی در تصمیمگیریهای حساس و حیاتی منطقی است؟

مقاله حاضر با ساختاری منسجم و گام به گام، به بررسی جامع هوش مصنوعی جعبه سیاه میپردازد. در ابتدا، مفهوم و نحوه عملکرد این نوع هوش مصنوعی تشریح میشود. سپس، پیامدها و چالشهای استفاده از آن مورد بحث قرار میگیرد. در ادامه، به مقایسه هوش مصنوعی جعبه سیاه با هوش مصنوعی جعبه سفید پرداخته میشود و در نهایت، اصول و ملاحظات اخلاقی در استفاده از این فناوری بررسی میگردد. این ساختار منطقی به خواننده کمک میکند تا درک عمیق و جامعی از موضوع به دست آورد.

فهرست مطالب

هوش مصنوعی جعبه سیاه چیست؟

هوش مصنوعی جعبه سیاه را میتوان به سیستمی تشبیه کرد که مانند یک جعبهی سر بسته عمل میکند. ما میدانیم که چه اطلاعاتی وارد این جعبه میشود و چه نتیجهای از آن خارج میشود؛ اما نمیتوانیم ببینیم که در داخل این جعبه چه اتفاقی میافتد و اطلاعات ورودی چگونه به نتیجه خروجی تبدیل میشوند. به عبارت دیگر، مکانیسم و کارکرد داخلی این سیستم برای ما ناشناخته است.

مدلهای هوش مصنوعی جعبه سیاه به ما پاسخ میدهند یا تصمیماتی میگیرند، اما نمیتوانند توضیح دهند که چگونه به این پاسخها یا تصمیمها رسیدهاند. این مدلها شبیه به شبکههای پیچیدهای از نورونهای مصنوعی هستند که اطلاعات را در میان خود پخش میکنند. این پیچیدگی بسیار زیاد است و درک آن برای انسان بسیار دشوار است، درست مانند درک نحوه کار مغز انسان. در واقع، ما نمیدانیم که چه عواملی در داخل این مدلها باعث ایجاد نتایج میشوند.

در مقابل هوش مصنوعی جعبه سیاه، هوش مصنوعی قابل توضیح قرار دارد. این نوع هوش مصنوعی به گونهای طراحی میشود که بتوانیم به راحتی درک کنیم که چگونه به نتایج خود میرسد. به عبارت دیگر، این مدلها میتوانند منطق و فرایند تصمیمگیری خود را برای ما توضیح دهند.

هوش مصنوعی جعبه سیاه چگونه کار میکند؟

مدلهای یادگیری عمیق که امروزه در حوزه هوش مصنوعی بسیار پرکاربرد هستند، اغلب به صورت جعبه سیاه عمل میکنند. این مدلها حجم عظیمی از دادهها را دریافت کرده و با استفاده از الگوریتمهای پیچیده، ویژگیهای خاصی را در این دادهها شناسایی میکنند تا بتوانند خروجی مورد نظر را تولید کنند. این فرایند به طور معمول شامل مراحل زیر است:

- الگوریتمهای پیچیده مجموعه دادههای گستردهای را بررسی میکنند تا الگوها را بیابند. برای دستیابی به این هدف، تعداد زیادی نمونه داده به یک الگوریتم تغذیه میشود که به آن امکان میدهد از طریق آزمون و خطا به صورت خودآموز آزمایش کند و یاد بگیرد. مدل یاد میگیرد تا پارامترهای داخلی خود را تغییر دهد تا بتواند با استفاده از یک نمونه بزرگ از ورودیها و خروجیهای مورد انتظار، خروجی دقیق را برای ورودیهای جدید پیشبینی کند.

- پس از پایان فرآیند آموزش، مدل یادگیری ماشین آماده است تا با استفاده از دادههای دنیای واقعی، پیشبینیهای خود را انجام دهد. برای مثال، میتوان از این مدلها برای تشخیص تقلب در تراکنشهای مالی استفاده کرد. در این حالت، مدل به هر تراکنش امتیازی به عنوان میزان ریسک آن اختصاص میدهد.

- قابلیت یادگیری مستمر یکی از ویژگیهای مهم مدلهای یادگیری عمیق است. این مدلها میتوانند با جمعآوری دادههای جدید، دانش و تواناییهای خود را به مرور زمان افزایش دهند.

درک نحوه عملکرد داخلی مدلهای جعبه سیاه برای متخصصان حوزه داده و هوش مصنوعی بسیار چالشبرانگیز است. این مدلها به دلیل پیچیدگی بسیار زیاد و ماهیت خودکار عملکردشان، مانند یک جعبه سیاه عمل میکنند که محتوای داخلی آن قابل مشاهده نیست. اگرچه برخی روشها مانند تحلیل حساسیت و تجسم ویژگی میتوانند تا حدودی به ما در درک بهتر این مدلها کمک کنند، اما همچنان شفافیت کامل در مورد عملکرد داخلی آنها وجود ندارد.

پیامدهای هوش مصنوعی جعبه سیاه چیست؟

اکثر مدلهای یادگیری عمیق بر اساس رویکرد “جعبه سیاه” عمل میکنند. این بدان معناست که ما به طور دقیق نمیدانیم در درون این مدلها چه اتفاقی میافتد و تصمیمگیریها بر اساس چه معیارهایی صورت میگیرد. گرچه این رویکرد در برخی موارد مفید است، اما چالشهای قابل توجهی را نیز به همراه دارد:

تعصب و سوگیری هوش مصنوعی

هوش مصنوعی میتواند همانند آینهای، تعصبات موجود در جامعه را بازتاب دهد. این تعصبات ممکن است به صورت آگاهانه یا ناخودآگاه توسط طراحان سیستمهای هوش مصنوعی وارد شوند یا به دلیل نقص در دادههای آموزشی ایجاد شوند. به عنوان مثال، اگر دادههای آموزشی یک سیستم هوش مصنوعی عمدتاً شامل اطلاعاتی از یک گروه خاص باشد، این سیستم ممکن است نتایجی را تولید کند که برای سایر گروهها ناعادلانه یا تبعیضآمیز باشد.

یک مثال بارز از این مسئله، استفاده از هوش مصنوعی در فرایند استخدام است. اگر دادههای تاریخی نشان دهند که اکثر کارمندان یک شرکت در گذشته مرد بودهاند، هوش مصنوعی ممکن است به طور ناخودآگاه به سمت انتخاب نامزدهای مرد تمایل پیدا کند. این در حالی است که ممکن است نامزدهای زن صلاحیتهای لازم برای انجام کار را داشته باشند.

اگر این نوع تعصبات در سیستمهای هوش مصنوعی شناسایی نشوند و اصلاح نشوند، میتوانند به شهرت سازمانها آسیب جدی وارد کنند و حتی منجر به پیگیریهای قانونی شوند. این مسئله تنها به جنسیت محدود نمیشود و میتواند در مورد سایر گروههای اجتماعی مانند نژاد، قومیت، مذهب و غیره نیز اتفاق بیفتد.

برای جلوگیری از چنین مشکلاتی، لازم است که توسعهدهندگان هوش مصنوعی به شفافیت در طراحی و عملکرد سیستمهای خود توجه کنند. همچنین، وضع قوانین و مقررات مناسب در حوزه هوش مصنوعی و ایجاد حس مسئولیتپذیری در میان توسعهدهندگان میتواند به کاهش تعصبات در سیستمهای هوش مصنوعی کمک کند.

عدم شفافیت و پاسخگویی

شبکههای عصبی مصنوعی به قدری پیچیده شدهاند که درک دقیق عملکرد داخلی آنها حتی برای متخصصان نیز دشوار است. این شبیه به این است که بخواهیم عملکرد یک جعبه سیاه را بدون باز کردن آن درک کنیم. با وجود اینکه این شبکهها میتوانند نتایج بسیار دقیقی تولید کنند، اما پیچیدگی بیش از حد آنها باعث میشود که نتوانیم به طور کامل به آنها اعتماد کنیم و نحوه تصمیمگیری آنها را به طور دقیق بررسی کنیم.

این عدم شفافیت در حوزههای حساس مانند پزشکی، بانکداری و سیستم قضایی میتواند بسیار خطرناک باشد. تصور کنید که یک سیستم هوش مصنوعی در حوزه پزشکی تصمیماتی مهمی در مورد درمان بیماران بگیرد، اما ما ندانیم که این سیستم بر اساس چه معیارهایی به این تصمیمات رسیده است. در چنین شرایطی، در صورت بروز هرگونه خطا، نمیتوانیم به راحتی علت آن را پیدا کرده و آن را برطرف کنیم.

یکی دیگر از مشکلات عدم شفافیت در سیستمهای هوش مصنوعی، مسئله مسئولیتپذیری است. اگر یک سیستم هوش مصنوعی تصمیم اشتباهی بگیرد و به فردی آسیب برساند، چه کسی باید مسئولیت این اتفاق را بر عهده بگیرد؟ پاسخ به این سوال زمانی که ما درک کاملی از نحوه عملکرد این سیستمها نداریم، بسیار دشوار است.

عدم انعطاف پذیری

یکی از چالشهای اصلی در استفاده از سیستمهای هوش مصنوعی جعبه سیاه، انعطافناپذیری آنها است. این سیستمها به گونهای طراحی شدهاند که پس از آموزش، تغییرات در آنها بسیار دشوار و زمانبر است. به عنوان مثال، اگر بخواهیم یک مدل هوش مصنوعی را به گونهای تغییر دهیم که بتواند شیء جدیدی را تشخیص دهد یا وظیفه متفاوتی را انجام دهد، باید تغییرات گستردهای در ساختار و پارامترهای آن ایجاد کنیم که این کار بسیار پیچیده و وقتگیر است.

به دلیل همین عدم انعطافپذیری، استفاده از مدلهای هوش مصنوعی جعبه سیاه برای پردازش دادههای حساس توصیه نمیشود. تصور کنید که از یک مدل هوش مصنوعی برای تصمیمگیری در مورد مسائل مهمی مانند اعطای وام یا استخدام افراد استفاده میکنیم. اگر در آینده متوجه شویم که این مدل دارای تعصبات یا خطاهایی است، تغییر و اصلاح آن بسیار دشوار خواهد بود. در نتیجه، ممکن است تصمیمات نادرستی گرفته شود که عواقب جدی برای افراد داشته باشد.

نقصهای امنیتی

سیستمهای هوش مصنوعی جعبه سیاه، در برابر حملات سایبری آسیبپذیر هستند. این سیستمها به دلیل پیچیدگی بسیار زیاد و عدم شفافیت در عملکردشان، میتوانند به راحتی مورد سوءاستفاده قرار بگیرند. مهاجمان سایبری میتوانند با دستکاری دادههای ورودی به این سیستمها، آنها را فریب داده و باعث شوند تصمیمات نادرست و خطرناکی بگیرند.

چه زمانی باید از هوش مصنوعی جعبه سیاه استفاده کرد؟

در حالی که مدلهای یادگیری ماشین جعبه سیاه با چالشهایی همراه هستند، اما مزایای قابل توجهی نیز دارند. زمانی که موارد زیر در اولویت قرار میگیرند، استفاده از این مدلها میتواند بسیار مفید باشد:

- دقت بالا. سیستمهای هوش مصنوعی جعبه سیاه در انجام پیشبینیها، به ویژه در زمینههایی مانند تشخیص تصویر (بینایی کامپیوتر) و پردازش زبانهای طبیعی (NLP)، دقت بسیار بالایی دارند. این دقت بالا به دلیل توانایی این سیستمها در شناسایی الگوهای پیچیده و پنهانی در دادهها است که ممکن است انسان قادر به مشاهده آنها نباشد. با این حال، همین پیچیدگی که باعث افزایش دقت میشود، درک نحوه عملکرد دقیق این سیستمها را برای ما دشوار میکند.

- نتیجهگیری سریع. مدلهای جعبه سیاه اغلب شامل مجموعهای از قوانین و محاسبات ریاضی هستند که به آنها اجازه میدهد نتایج را به سرعت و به طور کارآمد تولید کنند. به عنوان مثال، برای محاسبه مساحت زیر یک منحنی، این مدلها میتوانند از روشهای ریاضی پیچیدهای استفاده کنند بدون اینکه لزوماً به درک عمیقی از ماهیت مسئله نیاز داشته باشند.

- منابع محاسباتی. یکی دیگر از مزایای این مدلها، نیاز کم آنها به منابع محاسباتی است. به دلیل ساختار سادهتر نسبت به برخی دیگر از مدلهای هوش مصنوعی، این سیستمها میتوانند با استفاده از سختافزارهای رایانهای معمولی اجرا شوند.

- خودکارسازی. از مهمترین کاربردهای هوش مصنوعی جعبه سیاه، میتوان به خودکارسازی فرآیندهای تصمیمگیری اشاره کرد. این سیستمها قادرند وظایف پیچیده و تکراری را به صورت خودکار انجام دهند و به این ترتیب، به کاهش دخالت انسان و افزایش بهرهوری کمک کنند.

هوش مصنوعی مسئول (Responsible AI) چیست؟

وقتی از هوش مصنوعی صحبت میکنیم، علاوه بر تواناییهای شگفتانگیزش، باید به این نکته نیز توجه کنیم که این فناوری باید به گونهای توسعه و استفاده شود که به نفع انسان و جامعه باشد. به همین دلیل، مفهوم “هوش مصنوعی مسئول” یا RAI مطرح شده است. RAI به این معناست که در طراحی و استفاده از هوش مصنوعی، اصول اخلاقی و اجتماعی را مد نظر قرار دهیم.

اخلاق هوش مصنوعی یا هوش مصنوعی اخلاقی | آینده پایدار با توسعه فناوریهای مسئولانه

یکی از دلایل اصلی اهمیت دادن به RAI، کاهش خطرات ناشی از هوش مصنوعی است. مثلاً، هوش مصنوعیهایی که عملکردشان برای ما نامشخص است (جعبه سیاه) یا آنهایی که دارای تعصبات هستند، میتوانند به شهرت سازمانها آسیب بزنند و حتی مشکلات قانونی ایجاد کنند. به همین دلیل، اصول و دستورالعملهایی برای توسعه و استفاده مسئولانه از هوش مصنوعی تدوین شده است که هدفشان محافظت از مصرفکنندگان و تولیدکنندگان است.

اگر رویههای هوش مصنوعی به اصول راهنمای زیر پایبند باشند، مسئولانه تلقی میشوند:

- انصاف در هوش مصنوعی: یکی از مهمترین اصول در توسعه و استفاده از هوش مصنوعی، برخورد عادلانه با همه افراد است. یک سیستم هوش مصنوعی مسئول باید از ایجاد تبعیض یا تقویت نابرابریهای موجود در جامعه خودداری کند. به عبارت دیگر، این سیستم باید به گونهای طراحی شود که همه افراد، صرف نظر از نژاد، جنسیت، قومیت و سایر ویژگیهای شخصی، فرصتهای برابر داشته باشند.

- شفافیت در هوش مصنوعی: شفافیت به معنای آن است که سیستم هوش مصنوعی به گونهای طراحی شود که عملکرد و تصمیمات آن برای کاربران و افرادی که تحت تأثیر آن قرار میگیرند، قابل درک و توضیح باشد. همچنین، توسعهدهندگان هوش مصنوعی باید اطلاعات کاملی در مورد دادههایی که برای آموزش سیستم استفاده شده است، در اختیار عموم قرار دهند. این شفافیت به کاربران کمک میکند تا به سیستم اعتماد کنند و همچنین به پژوهشگران اجازه میدهد تا سیستم را بهتر بررسی و بهبود بخشند.

- مسئولیتپذیری در هوش مصنوعی: یکی از اصول اساسی در توسعه و استفاده از هوش مصنوعی، اصل مسئولیتپذیری است. به عبارت سادهتر، سازمانها و افرادی که در طراحی، توسعه و استفاده از سیستمهای هوش مصنوعی نقش دارند، باید پاسخگوی تصمیمات و اقداماتی باشند که این سیستمها انجام میدهند. این اصل به این معناست که در صورت بروز هرگونه مشکل یا آسیب ناشی از عملکرد هوش مصنوعی، مسئولیت آن بر عهده افرادی است که این سیستم را ایجاد یا به کار گرفتهاند.

- توسعه مداوم و نظارت بر هوش مصنوعی: هوش مصنوعی یک فناوری پویا و در حال تکامل است. بنابراین، برای اطمینان از اینکه سیستمهای هوش مصنوعی همواره با اصول اخلاقی و هنجارهای اجتماعی مطابقت دارند، نیاز به نظارت و بهروزرسانی مداوم وجود دارد.

- اهمیت نظارت انسانی بر هوش مصنوعی: حتی با پیشرفتهای چشمگیر در حوزه هوش مصنوعی، همچنان نیاز به نظارت انسانی بر این سیستمها وجود دارد. به عبارت دیگر، سیستم هوش مصنوعی باید به گونهای طراحی شود که در مواقع ضروری، انسان بتواند در عملکرد آن دخالت کند و تصمیمات نهایی را اتخاذ کند. این امر به ویژه در مواردی که سیستم با مسائل پیچیده و اخلاقی روبرو میشود، اهمیت بیشتری پیدا میکند.

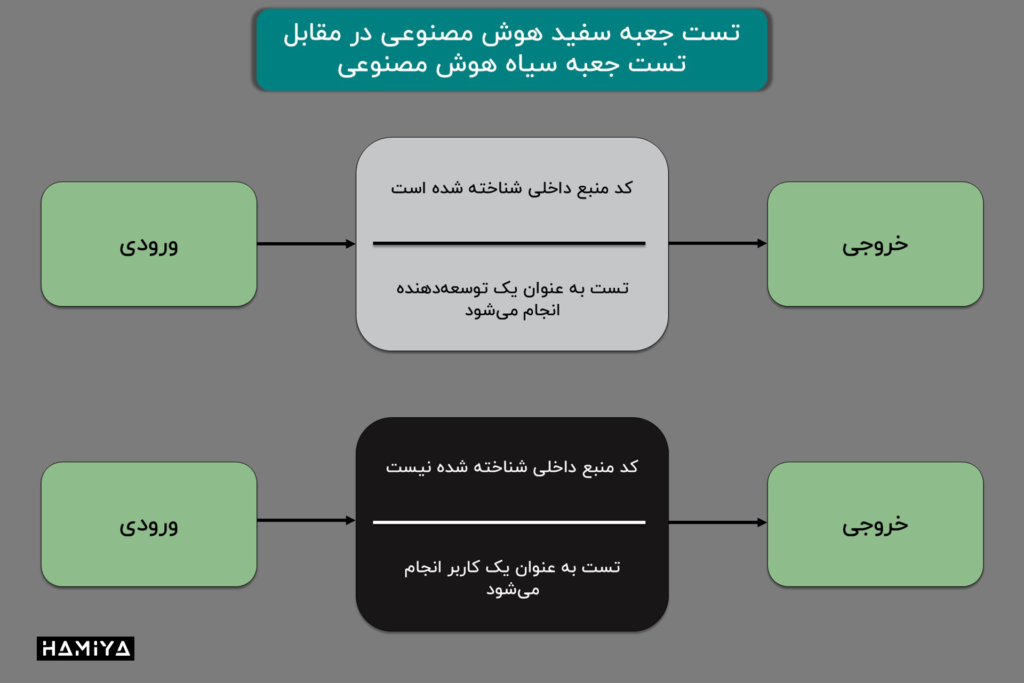

هوش مصنوعی جعبه سیاه در مقابل هوش مصنوعی جعبه سفید

هوش مصنوعی جعبه سیاه و جعبه سفید دو روش متفاوت برای ساختن سیستمهای هوشمند هستند. انتخاب اینکه کدام روش مناسبتر است به کاربردی که میخواهیم هوش مصنوعی را برای آن استفاده کنیم بستگی دارد.

در هوش مصنوعی جعبه سیاه، ما میدانیم که چه دادههایی وارد سیستم میشود و چه نتیجهای از آن خارج میشود، اما نمیتوانیم دقیقا بگوییم که سیستم داخل خود چگونه کار میکند و به آن نتیجه میرسد. این مثل یک جعبه سیاه است که نمیتوانیم داخل آن را ببینیم. در مقابل، هوش مصنوعی جعبه سفید به ما اجازه میدهد تا ببینیم که سیستم چگونه تصمیم میگیرد. مثلاً، یک دانشمند داده میتواند کدهای این نوع هوش مصنوعی را بررسی کند و بفهمد که چه عواملی در تصمیمگیری آن نقش دارند.

یکی از رایجترین روشها برای ساختن هوش مصنوعی جعبه سیاه، استفاده از شبکههای عصبی عمیق است. در این روش، سیستم با استفاده از مقدار زیادی داده آموزش میبیند و به مرور زمان یاد میگیرد که چگونه مشکلات را حل کند. این روش در مواردی مانند تشخیص عکس و صدا بسیار موفق بوده است؛ جایی که هدف طبقهبندی یا شناسایی دقیق و سریع دادهها است.

از آنجایی که ما در هوش مصنوعی جعبه سفید میدانیم که سیستم چگونه کار میکند، از این نوع هوش مصنوعی بیشتر در مواردی استفاده میشود که تصمیمگیری بسیار مهم است. مثلاً در پزشکی یا امور مالی، جایی که باید بدانیم چرا سیستم به یک نتیجه خاص رسیده است.

در ادامه، چند ویژگی متمایز کننده هر دو نوع هوش مصنوعی آورده شده است:

- دقت و کارایی: هوش مصنوعی جعبه سیاه معمولاً در انجام وظایف خود دقیقتر و سریعتر عمل میکند. این بدان معناست که این نوع هوش مصنوعی میتواند با دقت بالاتری به نتایج مورد نظر برسد.

- قابلیت فهم: بر خلاف هوش مصنوعی جعبه سیاه، هوش مصنوعی جعبه سفید به گونهای طراحی شده است که عملکرد آن برای انسان قابل درک باشد. به عبارت دیگر، ما میتوانیم ببینیم که این نوع هوش مصنوعی چگونه به نتایج خود میرسد.

- مدلهای پیچیده: بسیاری از مدلهای هوش مصنوعی جعبه سیاه، مانند مدلهای تقویتکننده و جنگل تصادفی، بسیار پیچیده هستند و درک چگونگی کارکرد آنها دشوار است. این پیچیدگی باعث میشود که توضیح دادن تصمیمات این مدلها به زبان ساده، کاری چالشبرانگیز باشد.

- رفع اشکال و عیبیابی: به دلیل شفافیت بیشتر هوش مصنوعی جعبه سفید، پیدا کردن و رفع مشکلات در این نوع سیستمها آسانتر است. در مقابل، یافتن و برطرف کردن خطاها در هوش مصنوعی جعبه سیاه میتواند بسیار زمانبر و دشوار باشد.

- مدلهای سادهتر: هوش مصنوعی جعبه سفید معمولاً از مدلهای سادهتری مانند مدلهای خطی، درخت تصمیم و درخت رگرسیون استفاده میکند. این مدلها قابل فهمتر هستند و به ما اجازه میدهند تا به راحتی بفهمیم که سیستم چگونه به نتایج خود میرسد.

اگر محتوای ما برایتان جذاب بود و چیزی از آن آموختید، لطفاً لحظهای وقت بگذارید و این چند خط را بخوانید:

ما گروهی کوچک و مستقل از دوستداران علم و فناوری هستیم که تنها با حمایتهای شما میتوانیم به راه خود ادامه دهیم. اگر محتوای ما را مفید یافتید و مایلید از ما حمایت کنید، سادهترین و مستقیمترین راه، کمک مالی از طریق لینک دونیت در پایین صفحه است.

اما اگر به هر دلیلی امکان حمایت مالی ندارید، همراهی شما به شکلهای دیگر هم برای ما ارزشمند است. با معرفی ما به دوستانتان، لایک، کامنت یا هر نوع تعامل دیگر، میتوانید در این مسیر کنار ما باشید و یاریمان کنید. ❤️